Ti stai chiedendo cos'è e come funziona DeepSeek ovvero l'AI Cinese che da qualche giorno è sulla bocca di tutti? Hai sentito dire che si può utilizzare in locale il nuovissimo modello deepseek R1 con pochi semplici passi?

Se ti stai ponendo queste domande allora ti consiglio di seguirmi in questo articolo nel quale cercherò di far chiarezza su cos'è DeepSeek e soprattutto su come usare il nuovissimo modello deepseek R1 anche in locale.

I contenuti dell'articolo

Perché l’AI cinese DeepSeek sta scuotendo agenzie tech e mercati internazionali?

DeepSeek e più in particolare il modello R1, sta facendo tremare le big tech americane grazie a un modello open source altamente competitivo, ma soprattutto per il suo costo di addestramento estremamente basso rispetto a OpenAI e concorrenti similari.

Ecco alcuni numeri chiave:

- Costo di addestramento: DeepSeek-R1 sarebbe stato sviluppato con soli 50 milioni di dollari, mentre modelli come GPT-4 di OpenAI hanno richiesto investimenti stimati tra i 500 milioni e 1 miliardo di dollari.

- Efficienza computazionale: utilizza un’architettura Mixture of Experts (MoE), che attiva solo una parte del modello alla volta, riducendo il consumo di risorse rispetto ai modelli di OpenAI.

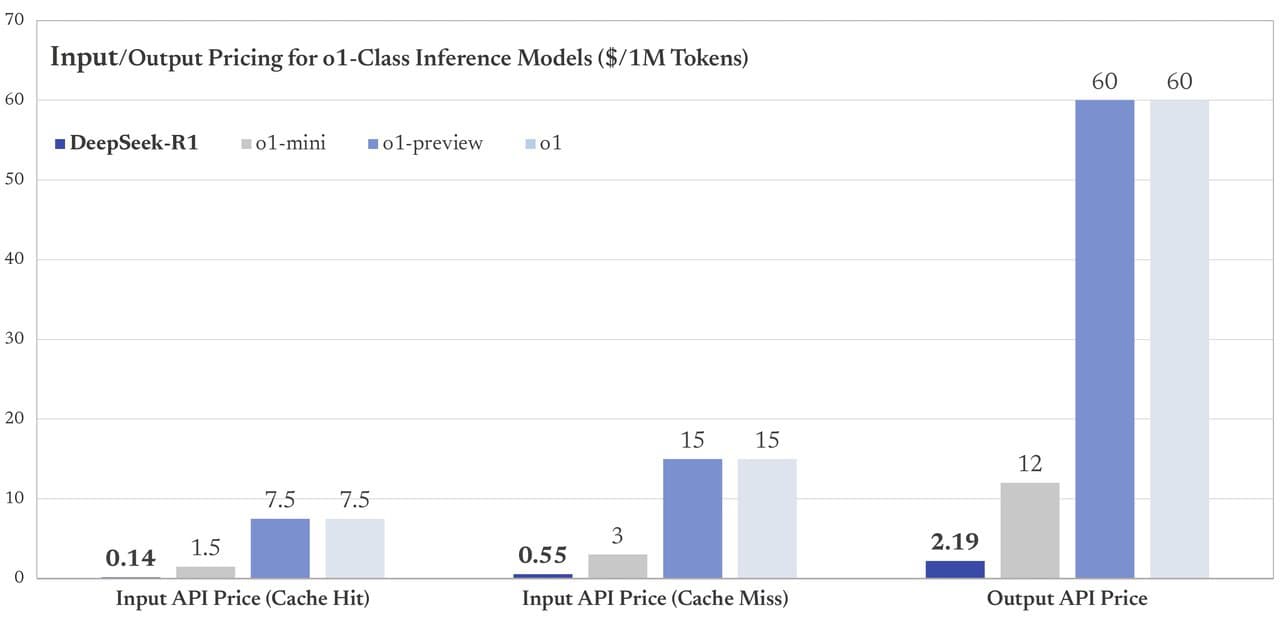

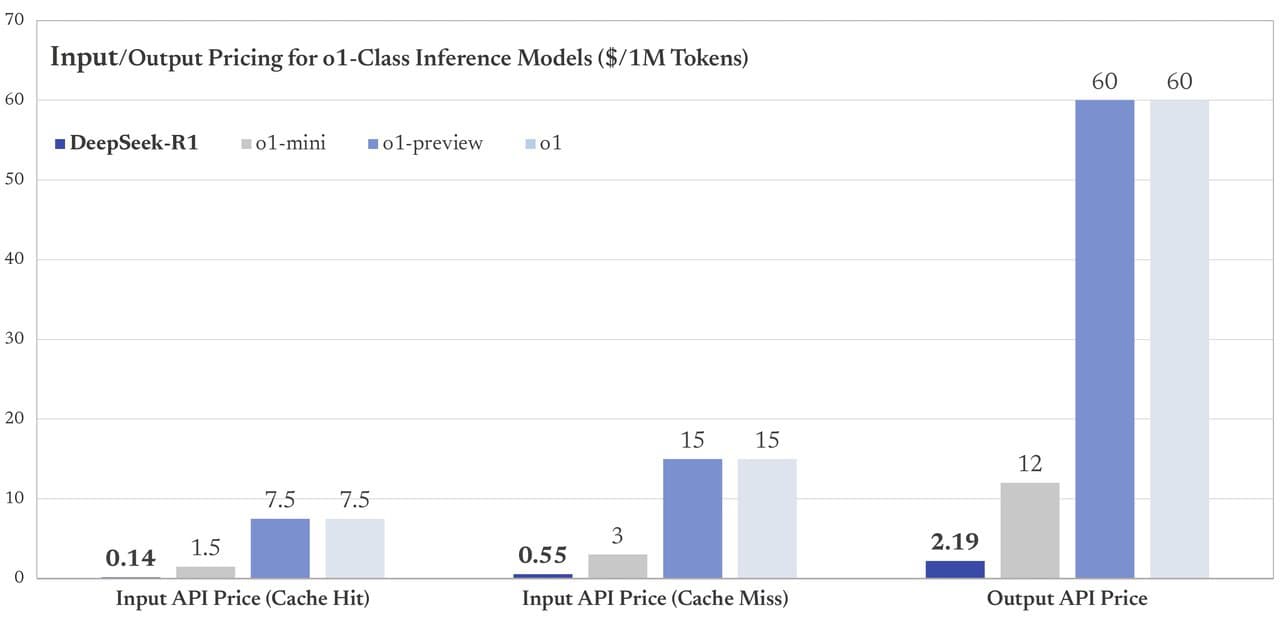

- Costo per inferenza: secondo alcuni analisti, le API di DeepSeek potrebbero offrire prezzi fino al 90% più bassi rispetto a quelle di OpenAI.

Questi numeri stanno mettendo in discussione il dominio occidentale sull’AI, al punto che Wall Street ha reagito con preoccupazione all’ascesa di DeepSeek (vedi crollo azioni di NVidia).

Questo il paper fornito DeepSeek in relazione alla differenza di costi nell'utilizzo di API tra il modello DeepSeek R1 ed i modelli o1 di ultima generazione di OpenAI

La cosa incredibile è che il nuovissimo modello DeepSeek R1 è in tutto paragonabile all'ultimo modello di OpenAI ovvero al modello 01 e 01-mini che ha introdotto il concetto di “thinking” ovvero di riflessione iniziale.

Come hanno sviluppato il nuovo modello R1

Per arrivare a questi incredibili risultati DeepSeek-AI ha sviluppato due nuovi modelli di intelligenza artificiale focalizzati sul ragionamento avanzato: DeepSeek-R1-Zero e DeepSeek-R1.

Il primo, DeepSeek-R1-Zero, è stato addestrato utilizzando esclusivamente il reinforcement learning (apprendimento per rinforzo), senza un primo passaggio di addestramento supervisionato. Questo approccio ha portato allo sviluppo di capacità di ragionamento molto avanzate, ma ha generato alcune difficoltà, come una minore leggibilità delle risposte e una gestione non ottimale delle lingue.

Per risolvere questi problemi e migliorare le prestazioni, DeepSeek-AI ha sviluppato DeepSeek-R1, un modello che utilizza un addestramento multi-fase e l’integrazione di dati “cold-start” prima del reinforcement learning. Grazie a questa strategia, DeepSeek-R1 raggiunge prestazioni comparabili a quelle di OpenAI-o1-1217 nei compiti di ragionamento.

Per supportare la comunità di ricerca, DeepSeek-AI ha inoltre reso disponibili in open-source DeepSeek-R1-Zero, DeepSeek-R1 e molte varianti di modelli “densi” con dimensioni che vanno da 1.5 miliardi a 671 miliardi di parametri.

Questi modelli sono stati rilasciati da DeepSeek-R1 e si basano su architetture consolidate come Qwen e Llama. In questo modo, i ricercatori possono accedere a strumenti avanzati per l’elaborazione del linguaggio naturale e lo sviluppo di nuove soluzioni basate sull’intelligenza artificiale.

Questo il paper

Per finire vediamo anche il paper fornito da DeepSeek che mette a confronto i modelli DeepSeek-R1, OpenAI-o1-1217, DeepSeek-R1-32B, OpenAI-o1-mini e DeepSeek-V3

DeepSeek-R1: modello di punta di DeepSeek paragonabile al modello OpenAI-o1-1217

DeepSeek-R1-32B: modello addestrato con 32 miliardi di parametri (pesa circa 20GB) paragonabile al modello OpenAI-o1-mini

DeepSeek-V3: modello senza Thinking paragonabile al modello GPT-4o di OpenAI

Se questi dati e queste stime di costi verranno confermate, DeepSeek potrebbe rappresentare una svolta epocale nel settore AI.

Ecco perché sto cercando di testarlo in profondità per capire se e come potrebbe davvero sostituire ChatGPT, in questo articolo infatti testeremo in locale il modello DeepSeek-R1:7b ovvero un modello addestrato con 7 miliardi di parametri e dal peso di circa 7 GB, abilitato al thinking ed usabile su macchine tradizionali (consumer) e non dedicate.

Il modello modello R1 Open Source

Come detto DeepSeek-R1 è un modello di intelligenza artificiale open source che si distingue per la sua architettura avanzata e per il suo sviluppo accessibile alla comunità AI. Questo modello è stato progettato per essere altamente efficiente grazie all'uso del Mixture of Experts (MoE), che consente di attivare solo una parte dei parametri del modello in ogni inferenza, ottimizzando così le prestazioni computazionali.

L'approccio open source di DeepSeek-R1 permette agli sviluppatori di personalizzare e adattare il modello alle proprie esigenze, senza dover dipendere da piattaforme cloud centralizzate. Grazie a questa filosofia, DeepSeek-R1 si posiziona come un'alternativa interessante a modelli proprietari come GPT-4, offrendo agli utenti un maggior controllo sulle operazioni del modello.

Uno degli aspetti più interessanti di DeepSeek-R1 è la sua disponibilità per l’esecuzione in locale, rendendolo ideale per applicazioni on-premise che richiedono elaborazione AI senza dipendenza da servizi esterni. Questo consente un maggiore rispetto della privacy e riduce i costi legati alle API di modelli commerciali.

Come installare Ollama e DeepSeek-R1

Per utilizzare in locale il modello Open Source DeepSeek R1 è necessario installare un software com Ollama ovvero uno strumento che permette di eseguire modelli AI in locale con un'interfaccia semplice e prestazioni ottimizzate per CPU e GPU.

Questi i passi da seguire per installare Ollama

Installare Ollama

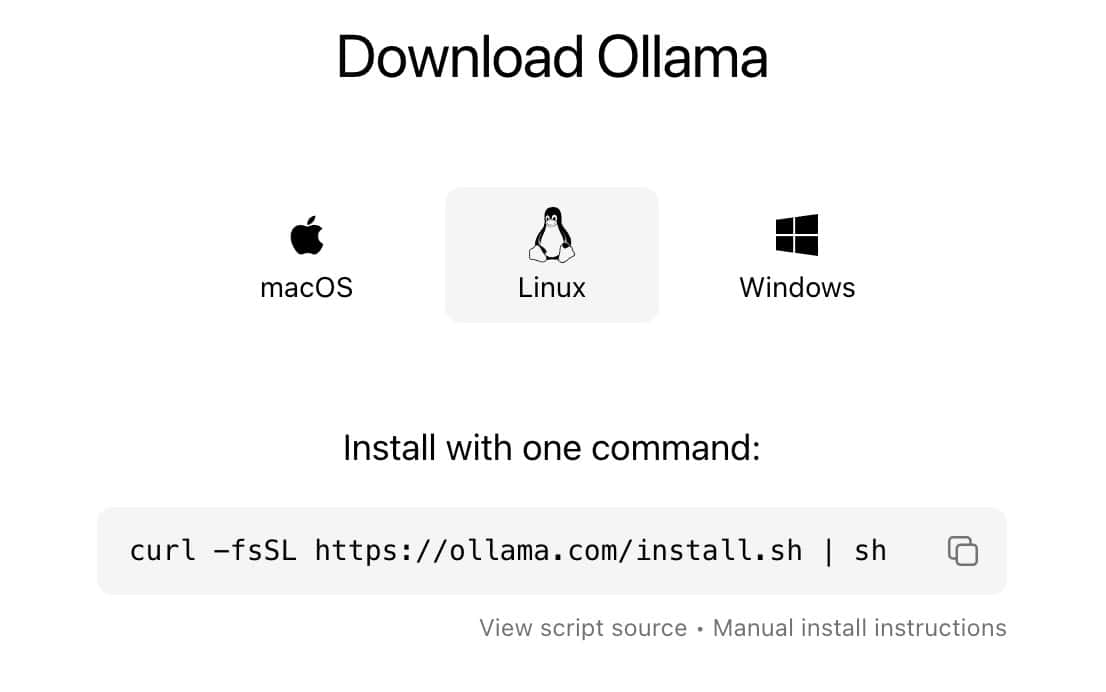

Per installare Ollama, accedi al sito web ufficiale https://ollama.com/ e clicca su Download

Seleziona poi il tuo sistema Operativo ed installa Ollama sul tuo PC

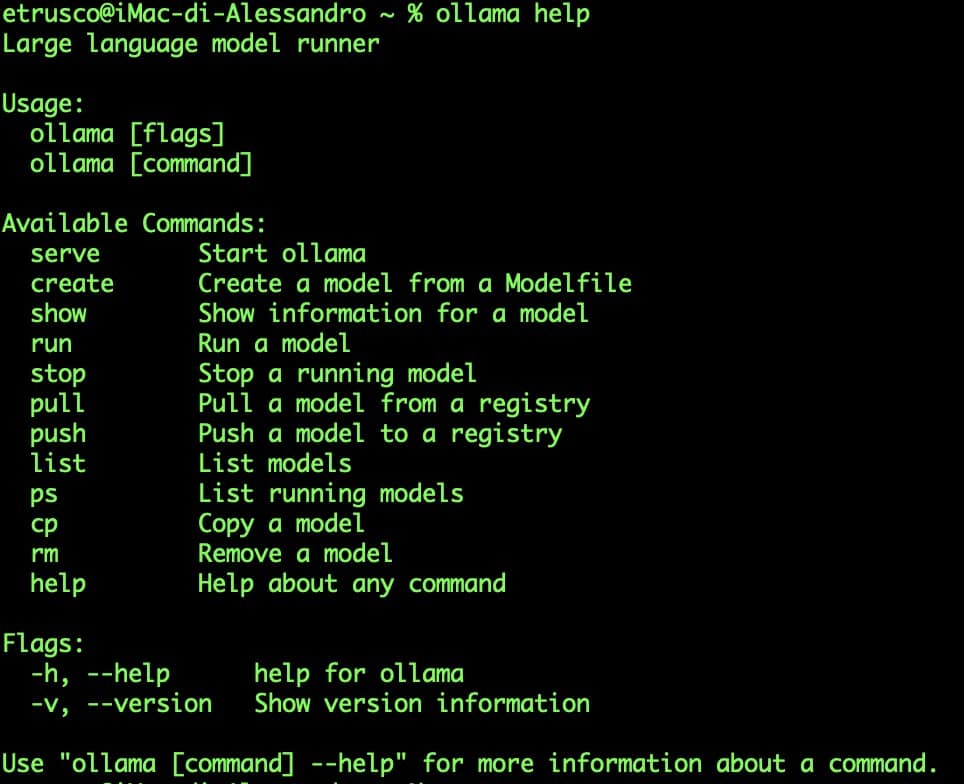

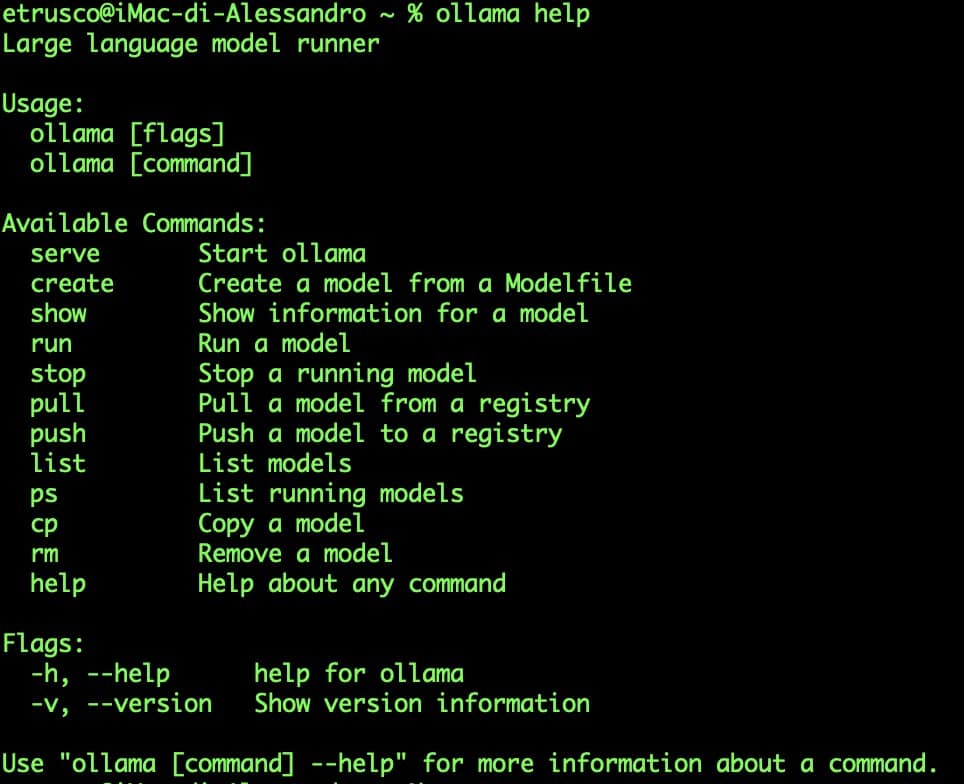

Una volta installato Ollama potrai testarne il corretto funzionamento da riga di comando:

ollama help

Se ottieni un risultato simile a questo allora hai installato Ollama correttamente.

Scaricare e installare il modello DeepSeek-R1

Dopo aver installato Ollama, puoi scaricare il modello DeepSeek-R1 in locale.

Come detto sopra ci sono molte versioni di dimensioni assai diverse, infatti come dimostra la seguente figura si passa dal più piccolo di solo 1.5 GB addestrato con 1.5 miliardi di parametri al più grande di oltre 400GB addestrato con circa 671 miliardi di parametri.

Considera che dai BenchMark è possibile paragonare il modello da 70b ovvero da (43GB) al modello OpenAI-01-mini ed il modello da 671b a OpenAI-01

Tutti i modelli li trovi a questo link https://ollama.com/library/deepseek-r1

e tutte le info sul sito web ufficiale https://api-docs.deepseek.com/news/news250120

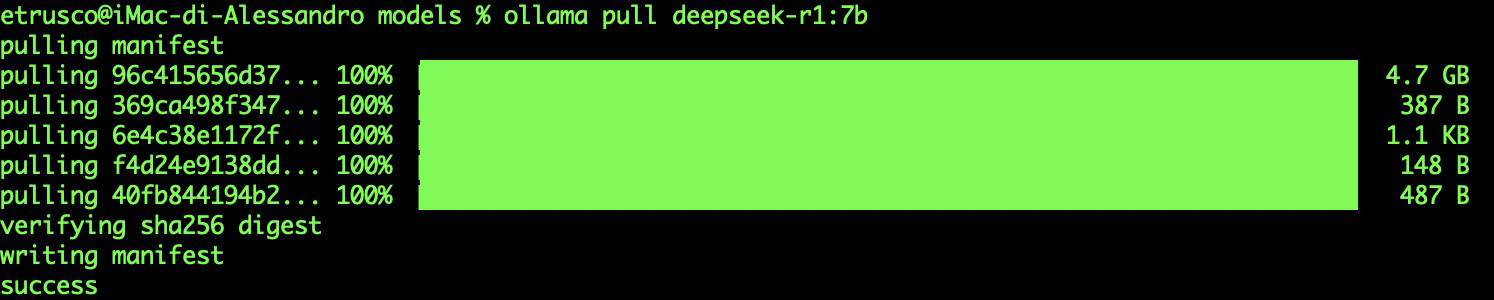

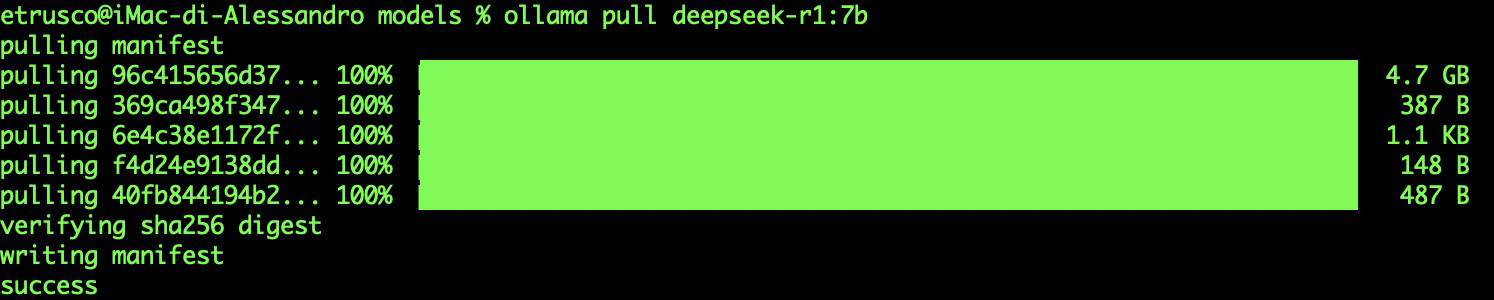

Per fare un semplice test usiamo il modello 7b da 4.7 GB ed installiamolo con il comando:

ollama pull deepseek-r1:7b

Questo comando scaricherà il modello da 4.7 GB e lo renderà disponibile per l'uso sulla macchina locale tramite ollama.

Come eseguire DeepSeek-R1 in locale

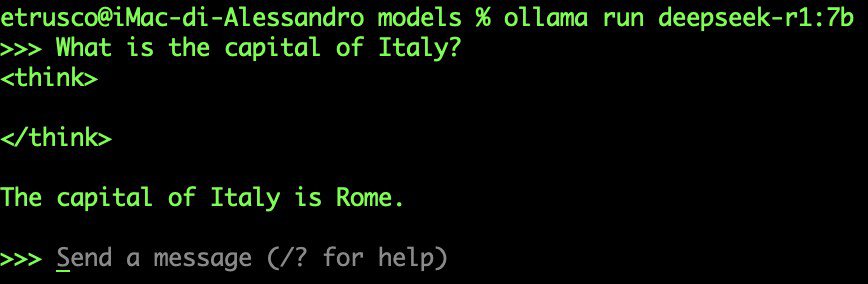

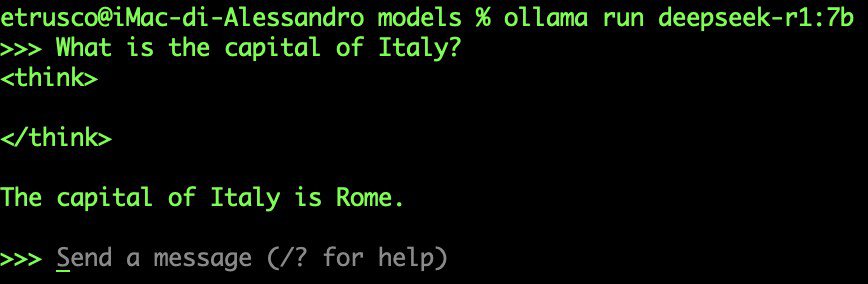

Una volta installato, puoi avviare il modello ed eseguire domande direttamente da terminale:

ollama run deepseek-r1:7b

Si aprirà il prompt per fare le domande al modello

![]()

![]()

Ora potrai interagire con il modello digitando domande in inglese (per ora, DeepSeek-R1 non supporta bene l'italiano nella versione Open Source da 4 GB):

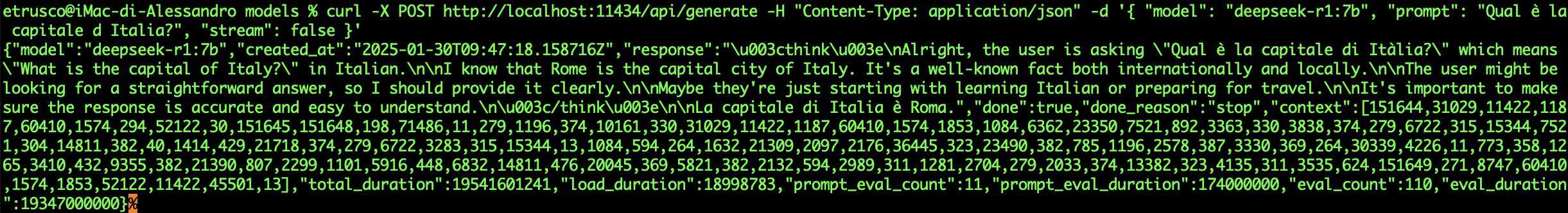

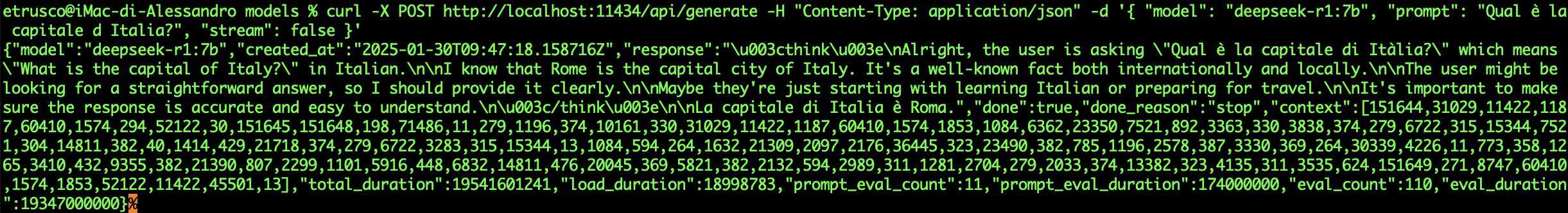

Se vuoi puoi anche integrare il modello in un’applicazione tramite l’API REST di Ollama.

Integrare DeepSeek-R1 in un progetto esterno tramite API Rest

Se desideri integrare DeepSeek-R1 in un progetto Esterno (Es java con Spring Boot) puoi usare le API di Ollama per inviare richieste e ottenere risposte.

Come prima cosa abilita l'API REST di Ollama con il comando:

ollama serve

Questo avvierà un'istanza locale dell'API su http://localhost:11434 facilmente integrabile in una web app

Una volta avviato il server sarà possibile integrarlo in qualsiasi applicazione sfruttando le potenzialità delle API Rest.

Ad esempio possiamo interrogare il modello usando cUrl in questo modo:

curl -X POST http://localhost:11434/api/generate \

-H "Content-Type: application/json" \

-d '{

"model": "deepseek-r1:7b",

"prompt": "Qual è la capitale d Italia?",

"stream": false

}'In questo modo otterremo una risposta simile a questa, con ben evidenziato il thinking ossia il ragionamento fatto dall'AI:

{

"model": "deepseek-r1:7b",

"created_at": "2025-01-30T09:47:18.158716Z",

"response": "<think>\nAlright, the user is asking

\"Qual è la capitale di Itàlia?\"

which means \"What is the capital of Italy?\" in Italian.\n\n

I know that Rome is the capital city of Italy.

It's a well-known fact both internationally and locally.\n\n

The user might be looking for a straightforward answer,

so I should provide it clearly.\n\n

Maybe they're just starting with learning Italian or preparing for travel.\n\n

It's important to make sure the response

is accurate and easy to understand.\n</think>\n\n

La capitale di Italia è Roma.",

"done": true,

"done_reason": "stop",

"context": [....],

"total_duration": 19541601241,

"load_duration": 18998783,

"prompt_eval_count": 11,

"prompt_eval_duration": 174000000,

"eval_count": 110,

"eval_duration": 19347000000

}come da figura

Ma ora facciamo un ulteriore passo in avanti e creiamo una chat in tutto simile a quella ufficiale di DeepSeek o di OpenAI usando docker e Ollama.

Integrare DeepSeek-R1 con Docker

Come prima cosa devi aver installato sulla tua macchina Docker Desktop, se non hai docker puoi scaricarlo ed installarlo dal sito ufficiale Docker

A questo punto accedi alla pagina Ollama dedicata ad Open Web UI su GitHub.

Cerca la sezione:

“Installation with Default Configuration >> If Ollama is on your computer, use this command:”

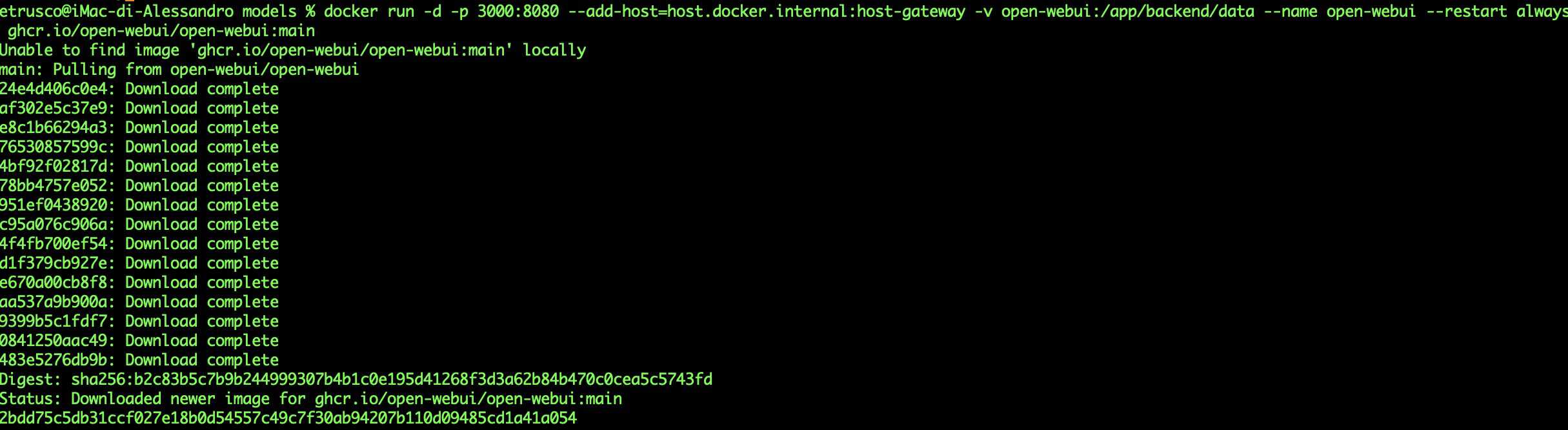

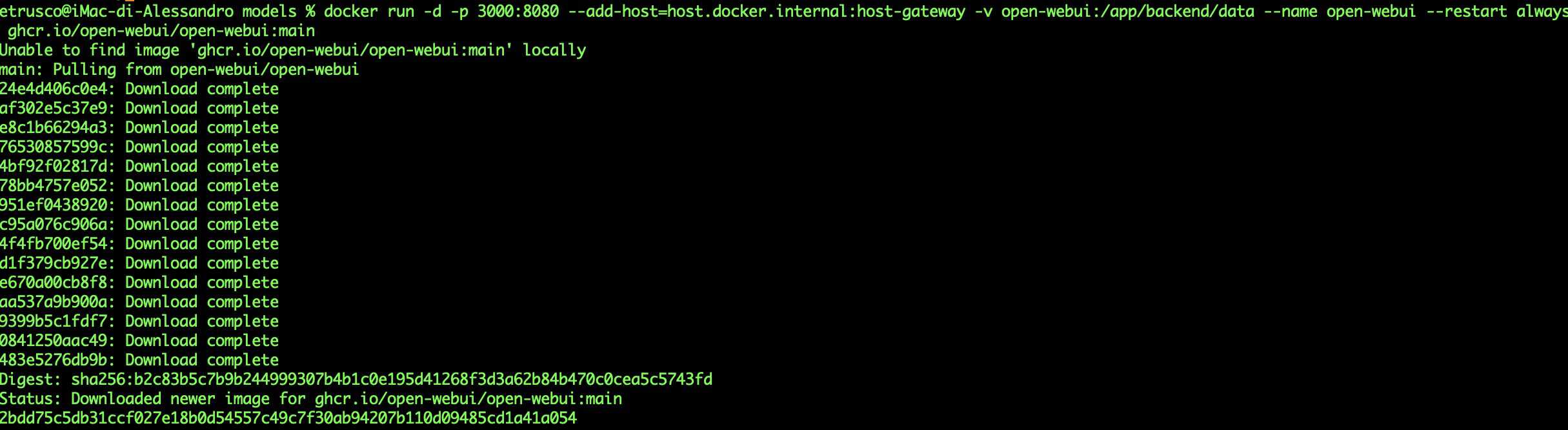

Copia il comando ed eseguilo da riga di comando:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Ora avrai scaricato l'immagine docker sul tuo pc, non ti resta che verificare che il container sia avviato:

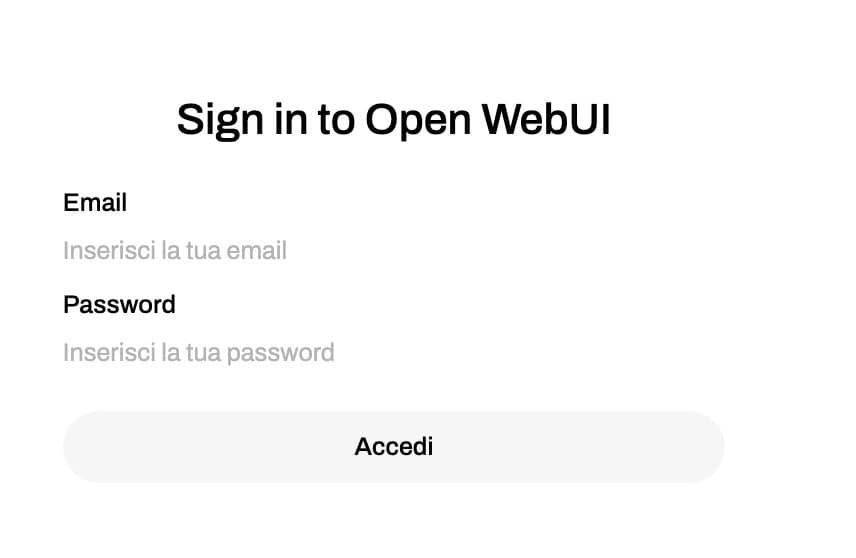

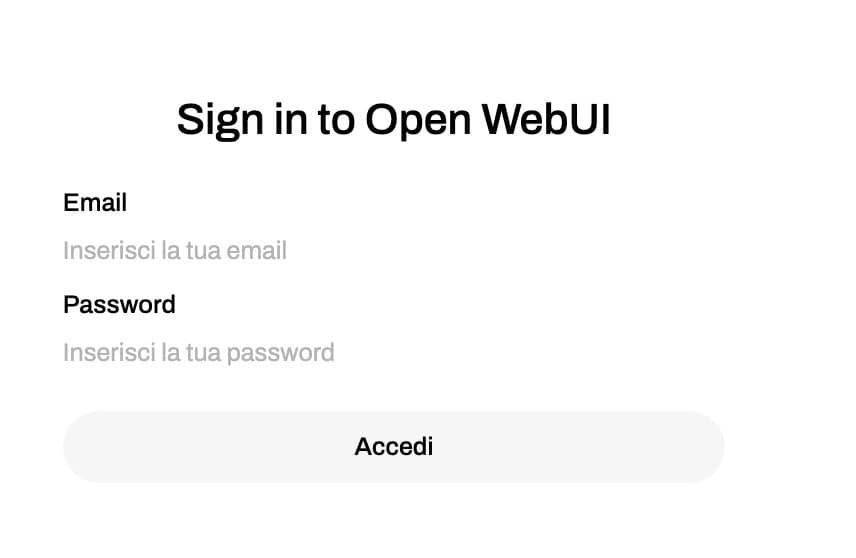

E poi lanciare dal browser il seguente url: http://localhost:3000

Inserisci una mail ed una password e poi clicca su Accedi

Seleziona il modello e comincia a testare il funzionamento dell'AI DeepSeek R1.

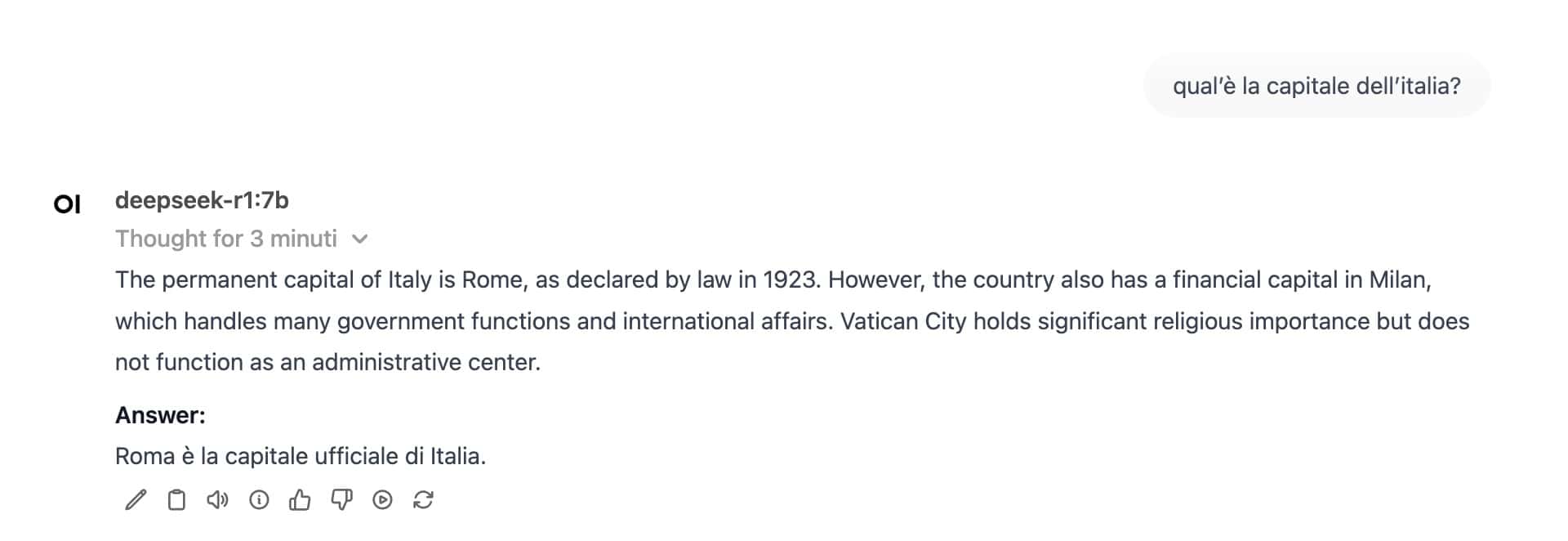

Questo il risultato per una semplicissima domanda, con evidenziato il ragionamento collaterale fatto.

La Video Recensione YouTube

Se vuoi saperne di più qui trovi la Video Recensione sul mio canale YouTube

Conclusioni

In questo articolo abbiamo analizzato le caratteristiche, per certi versi rivoluzionarie, del nuovissimo modello DeepSeek R1.

Come funziona DeepSeek ma soprattutto come si può utilizzare in locale il nuovissimo modello deepseek R1 con pochi semplici passi.

Se Benchmark e Costi verranno confermati sarà una vera e propria rivoluzione nel mondo dell'Intelligenza Artificiale che potrebbe mettere in seria difficoltà i colossi statunitensi come OpenAI e Google.

Staremo a vedere, intanto proviamo e godiamoci questo nuovo modello Cinese!

Che te ne pare di questo articolo? Hai potuto testare il nuovissimo modello R1 di DeepSeek? Se vuoi parliamo nei commenti!