Ti stai chiedendo cos’è e come funziona GPT-OSS, il nuovo modello open-source di OpenAI rilasciato con licenza Apache 2.0 che sta facendo parlare il mondo dell’AI? Hai sentito dire che puoi utilizzare in locale il nuovissimo modello GPT-OSS 20B con pochi semplici passi, direttamente sul tuo computer?

Se queste domande ti incuriosiscono, sei nel posto giusto: in questo articolo ti spiego in modo chiaro e completo cos’è GPT-OSS, perché rappresenta una svolta nel panorama dell’intelligenza artificiale e, soprattutto, ti mostro come installare ed eseguire GPT-OSS 20B in locale su un Mac con 16 GB di RAM usando Ollama.

I contenuti dell'articolo

Perché GPT-OSS di OpenAI sta riscrivendo le regole dell’intelligenza artificiale?

Il lancio di GPT-OSS, la nuova famiglia di modelli open-weight di OpenAI, sta attirando l’attenzione di sviluppatori, ricercatori e aziende di tutto il mondo. Per la prima volta, OpenAI – finora nota per modelli proprietari come GPT-3.5, GPT-4 e GPT-5 – rende pubblici i pesi di due modelli di linguaggio di ultima generazione, aprendo a scenari di trasparenza e innovazione mai visti prima.

Con GPT-OSS-20B e GPT-OSS-120B, OpenAI dimostra che anche modelli open-weight possono offrire ragionamento avanzato, efficienza computazionale e capacità di scalare su hardware di fascia consumer o enterprise, a seconda della versione.

Un modello progettato per l’efficienza

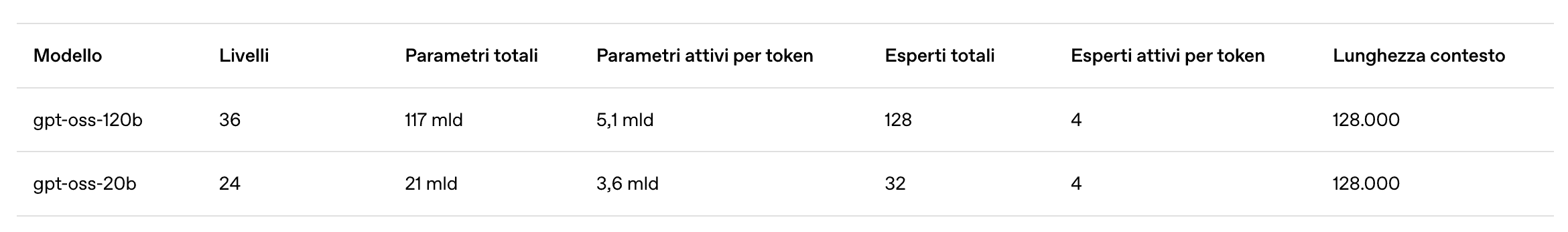

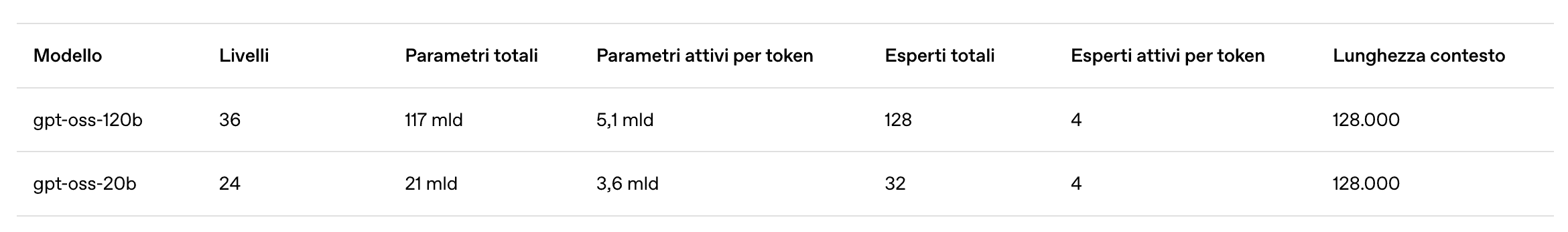

Uno dei punti più interessanti di GPT-OSS è la sua architettura avanzata. Entrambi i modelli sfruttano una strategia Mixture of Experts (MoE) che permette di attivare solo una parte dei parametri a ogni passo di inferenza. Questo significa che anche il modello più grande, GPT-OSS-120B, è in grado di fornire risposte estremamente accurate riducendo l’uso di risorse computazionali rispetto ai tradizionali modelli “densi”.

Questa attenzione all’efficienza consente di distribuire GPT-OSS-20B su macchine con soli 16 GB di RAM, rendendolo ideale per chi vuole sperimentare in locale, mentre il fratello maggiore GPT-OSS-120B richiede infrastrutture con GPU da circa 80 GB di memoria, tipiche dei data center.

Questi i dati relativi ai parametri

Licenza Apache 2.0: la rivoluzione open-weight

Il vero punto di svolta di GPT-OSS è la licenza Apache 2.0. Questa scelta consente a chiunque di scaricare, modificare, integrare e utilizzare i modelli GPT-OSS anche per scopi commerciali, senza vincoli restrittivi. È un cambio di paradigma per OpenAI, che ha sempre preferito mantenere i propri modelli principali dietro API a pagamento, offrendo ora una risorsa preziosa per la comunità di ricerca e per il mercato.

Innovazione tecnica e sicurezza

Oltre alla trasparenza dei pesi, GPT-OSS porta con sé alcune innovazioni tecniche di rilievo:

Lunghezza del contesto di 128.000 token, ideale per compiti complessi come analisi di documenti e ragionamento multi-step.

Supporto per structured output e catena di pensiero (Chain-of-Thought) per analisi più trasparenti.

Inferenza quantizzata in MXFP4, che riduce drasticamente il consumo di memoria mantenendo prestazioni elevate.

Un processo di valutazione rigoroso per garantire sicurezza, con test interni, collaborazione di ricercatori esterni e stress test mirati all’uso responsabile.

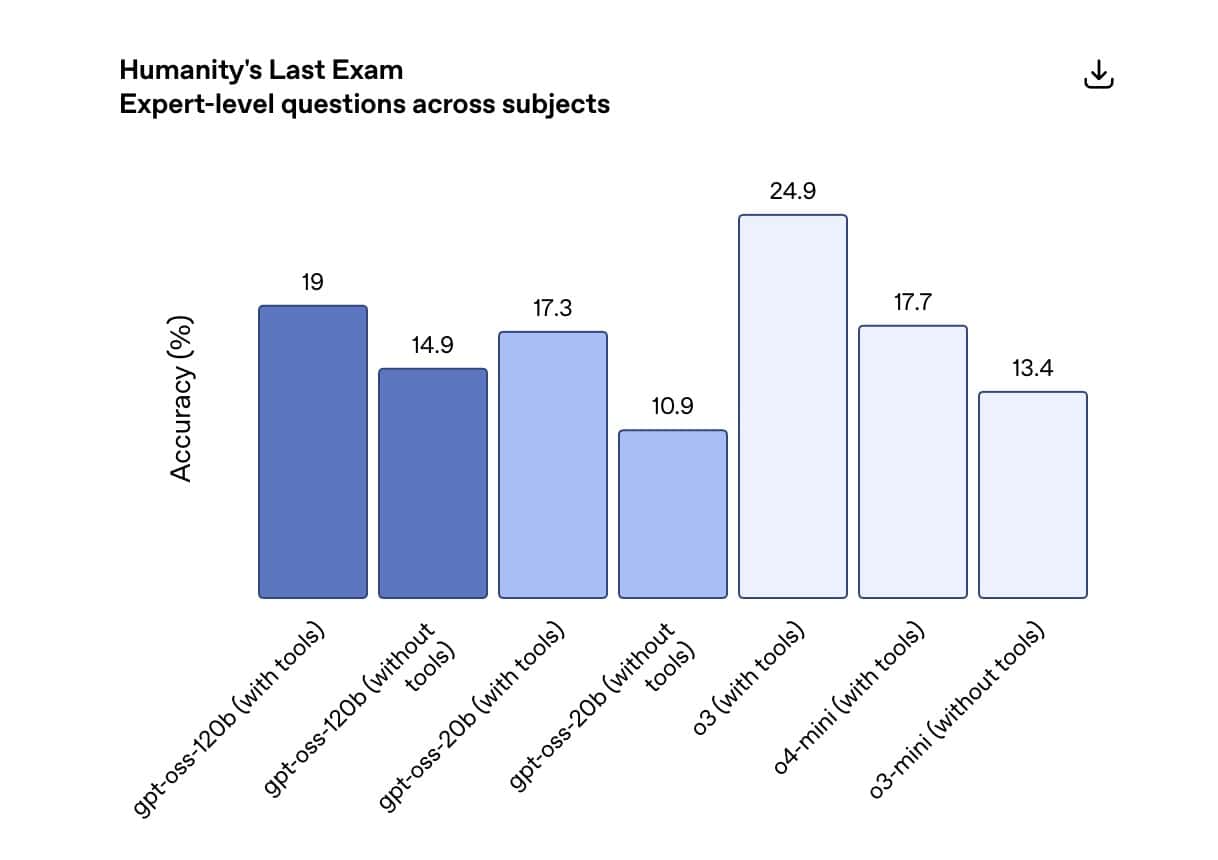

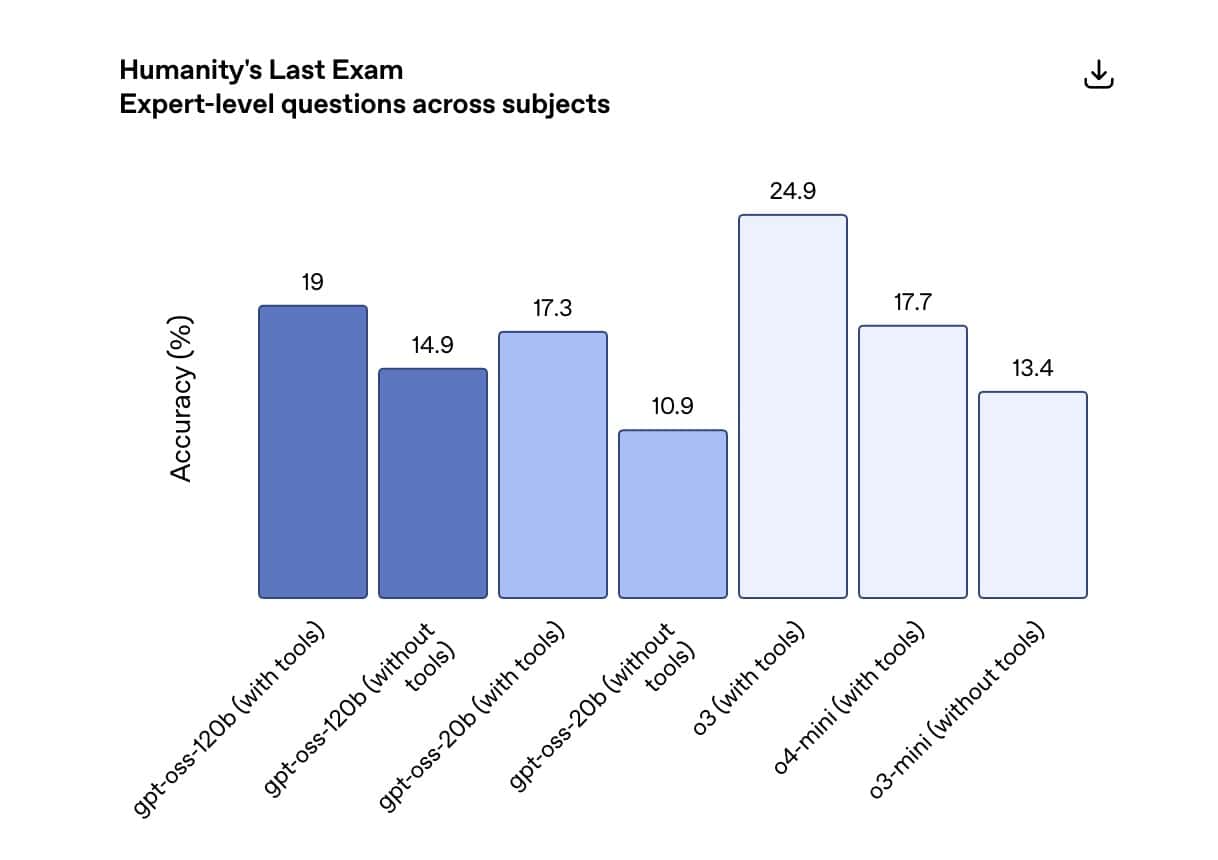

Valutazioni: GPT-OSS sorprende nei benchmark

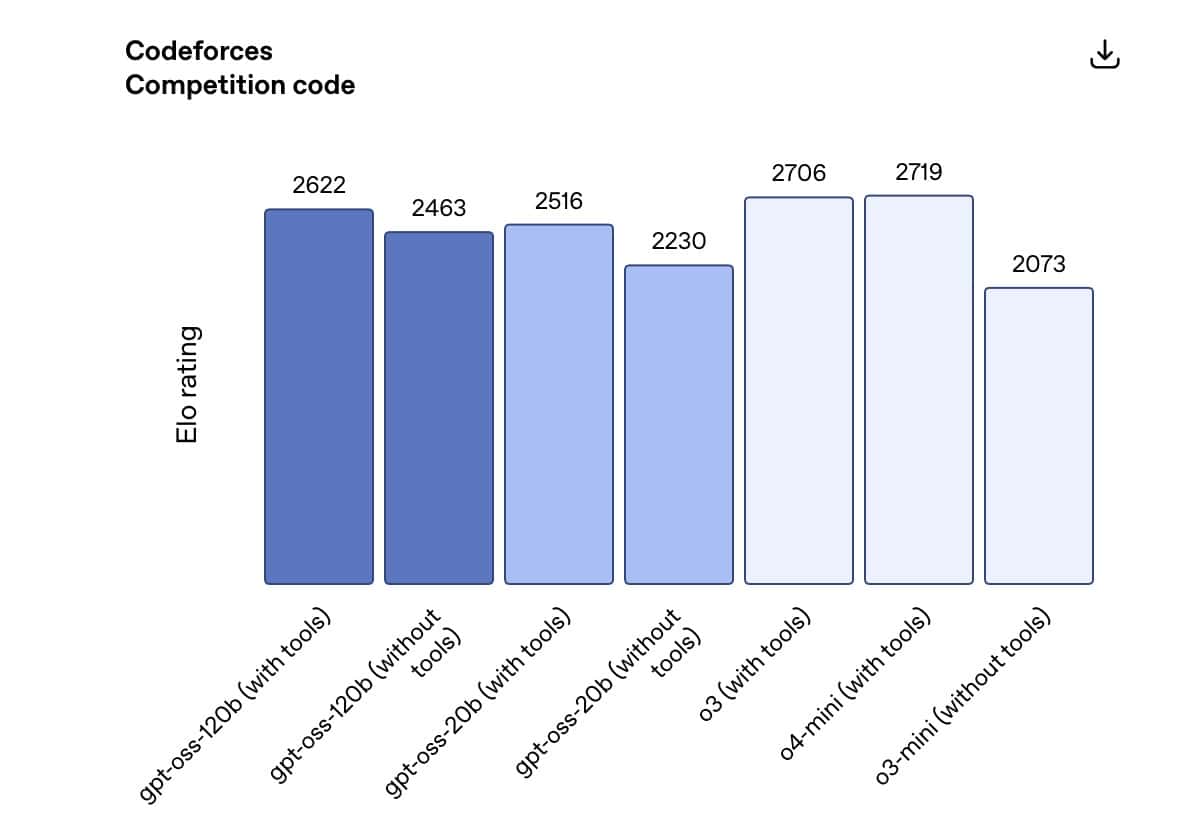

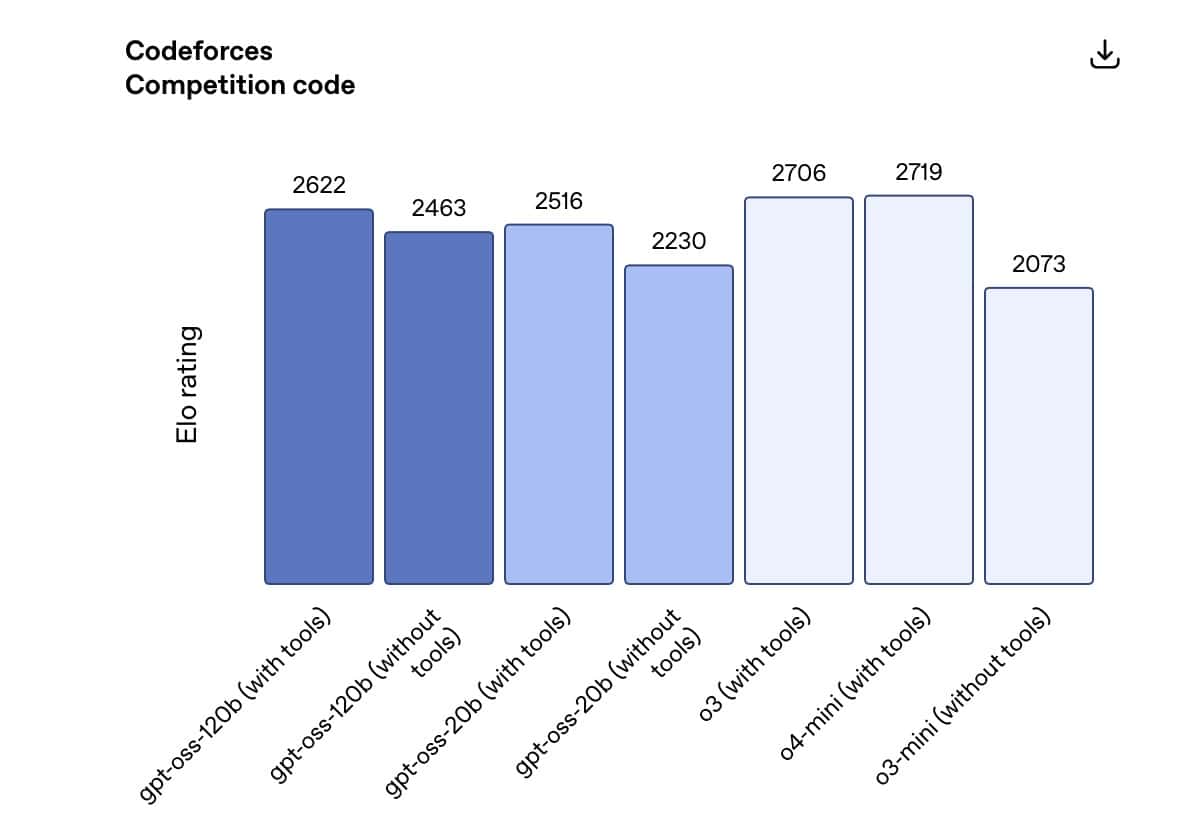

OpenAI ha condotto una serie di valutazioni approfondite sui modelli gpt-oss-120B e gpt-oss-20B, utilizzando benchmark accademici standard per analizzarne le capacità in programmazione competitiva, matematica avanzata, sanità e uso agentico degli strumenti. I risultati sono stati confrontati con quelli di altri modelli di ragionamento OpenAI come o3, o3-mini e o4-mini.

Il modello gpt-oss-120B ha dimostrato di superare o3-mini e di eguagliare o addirittura superare o4-mini in diversi ambiti chiave:

Codeforces: eccellenza nella programmazione competitiva;

MMLU e HLE: risoluzione generale di problemi;

TauBench: gestione avanzata degli strumenti;

HealthBench: prestazioni superiori persino a o4-mini nelle domande relative alla salute;

AIME 2024 e 2025: risultati eccezionali in matematica competitiva.

Sorprendentemente, anche gpt-oss-20B, pur avendo dimensioni molto più contenute, ha eguagliato o superato o3-mini nelle stesse valutazioni, mostrando addirittura risultati migliori in matematica e nel settore sanitario.

Questi dati evidenziano che GPT-OSS non è solo un esperimento di trasparenza, ma una soluzione altamente competitiva che ridefinisce gli standard dei modelli open-weight, mettendo a disposizione della comunità strumenti di livello enterprise anche per scenari di ricerca e sviluppo.

Questi alcuni benchmark, per la lista completa ti invito a visualizzare il paper ufficiale su OpenAI

Una risposta alla richiesta di modelli aperti

GPT-OSS rappresenta un punto d’incontro tra potenza e apertura: il modello da 20 miliardi di parametri è perfetto per chi vuole iniziare a sviluppare applicazioni AI avanzate senza dipendere da API proprietarie, mentre il modello da 120 miliardi di parametri offre una base di ricerca competitiva per università, aziende e laboratori.

Per la comunità, questo significa poter studiare e ottimizzare modelli di linguaggio di ultima generazione con la stessa libertà che fino ad oggi era garantita solo dai progetti open source indipendenti come LLaMA o Mistral, ma con la firma di una delle aziende leader del settore.

Ecco perché sto cercando di testarlo in profondità per capire se e come potrebbe davvero sostituire ChatGPT live, in questo articolo infatti testeremo in locale il modello gpt-oss:20b ovvero un modello addestrato con 21 miliardi di parametri e dal peso di circa 13 GB, abilitato al thinking ed usabile su macchine tradizionali (consumer) e non dedicate.

Per una soluzione professionale ed enterprise è invece consigliabile utilizzare gpt-oss:120b che richiede infrastrutture con GPU da circa 80 GB di memoria, tipiche dei data center.

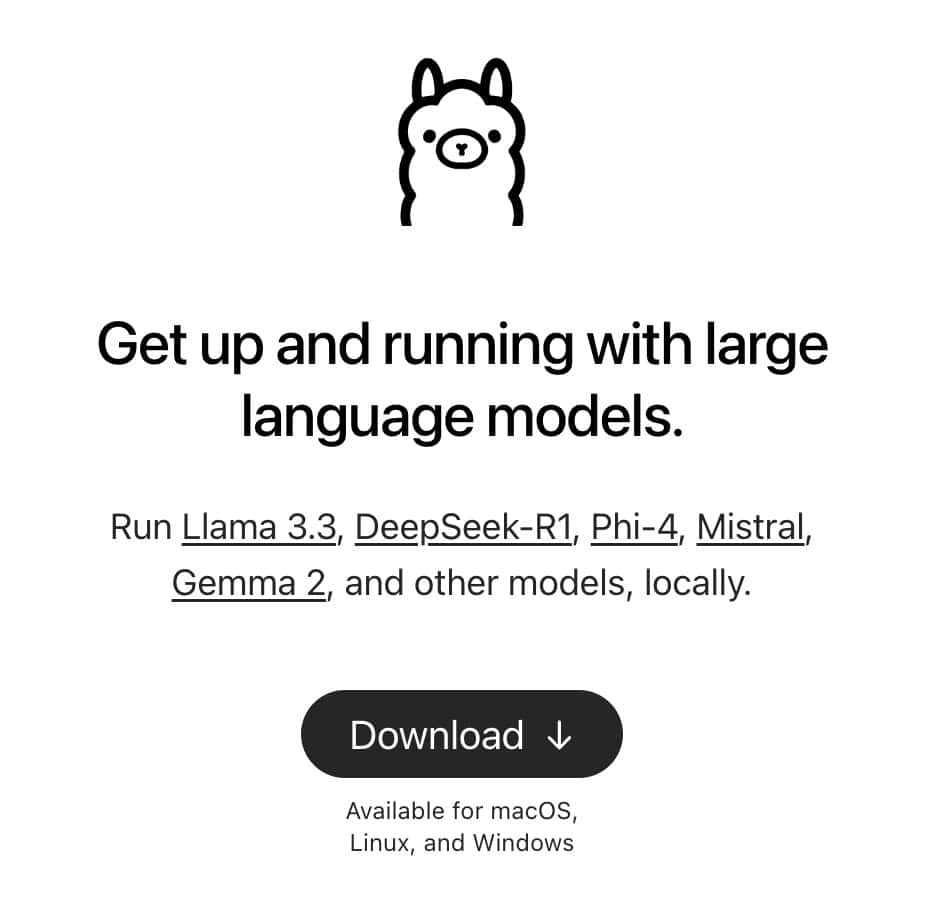

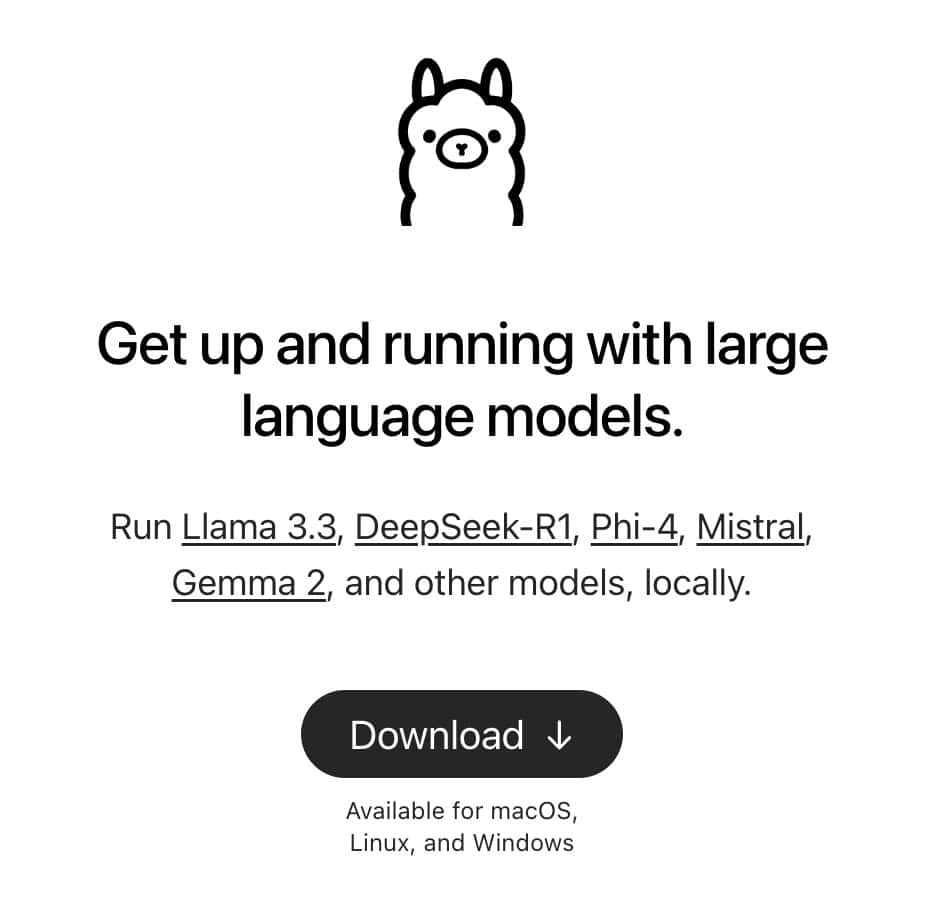

Come installare Ollama e GPT-OSS

Per utilizzare in locale il modello Open Source GPT-OSS è necessario installare Ollama ovvero uno strumento che permette di eseguire modelli AI in locale con un'interfaccia semplice e prestazioni ottimizzate per CPU e GPU.

Ne avevo parlato anche in questo articolo su DeepSeek R1

Questi i passi da seguire per installare Ollama

Installare Ollama

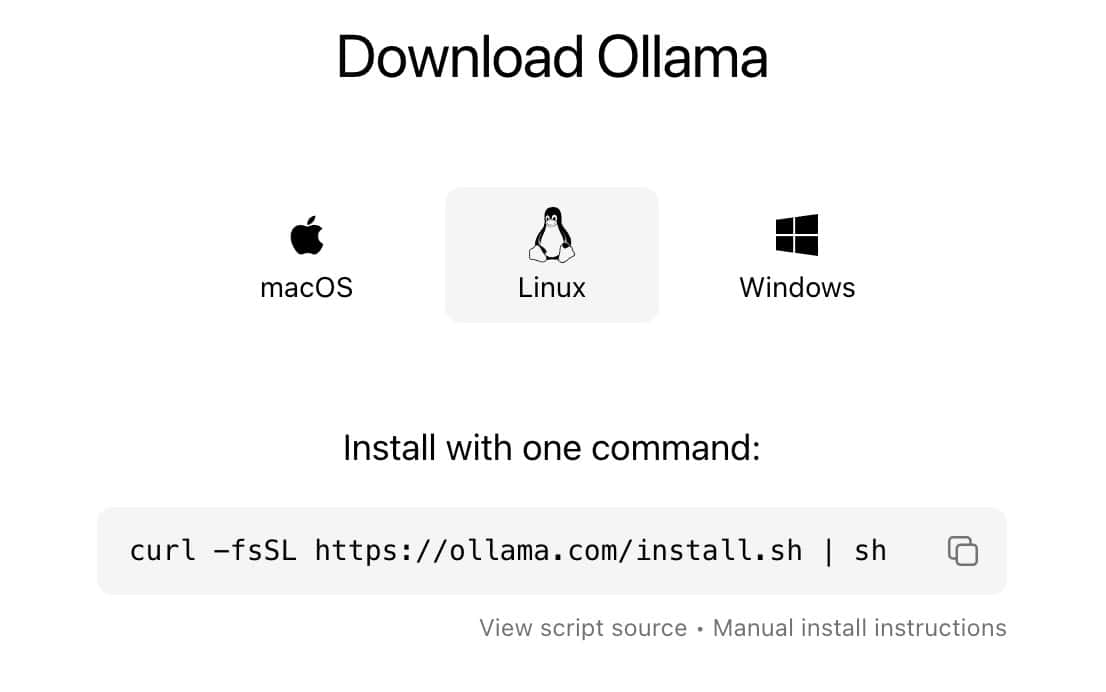

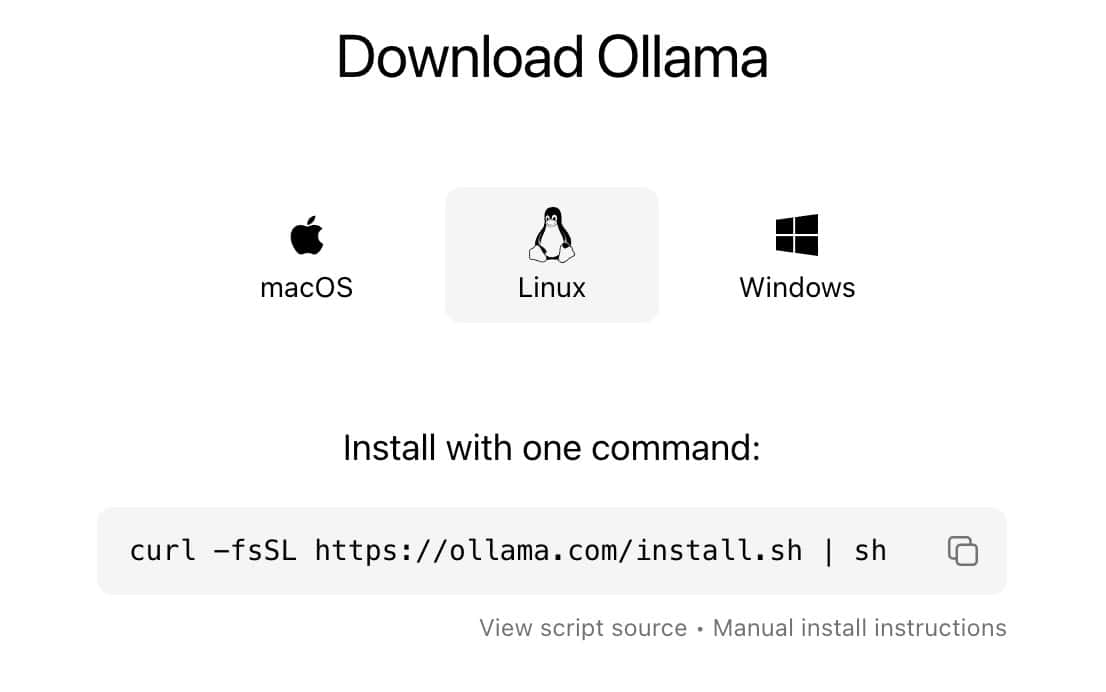

Per installare Ollama, accedi al sito web ufficiale https://ollama.com/ e clicca su Download

Seleziona poi il tuo sistema Operativo ed installa Ollama sul tuo PC

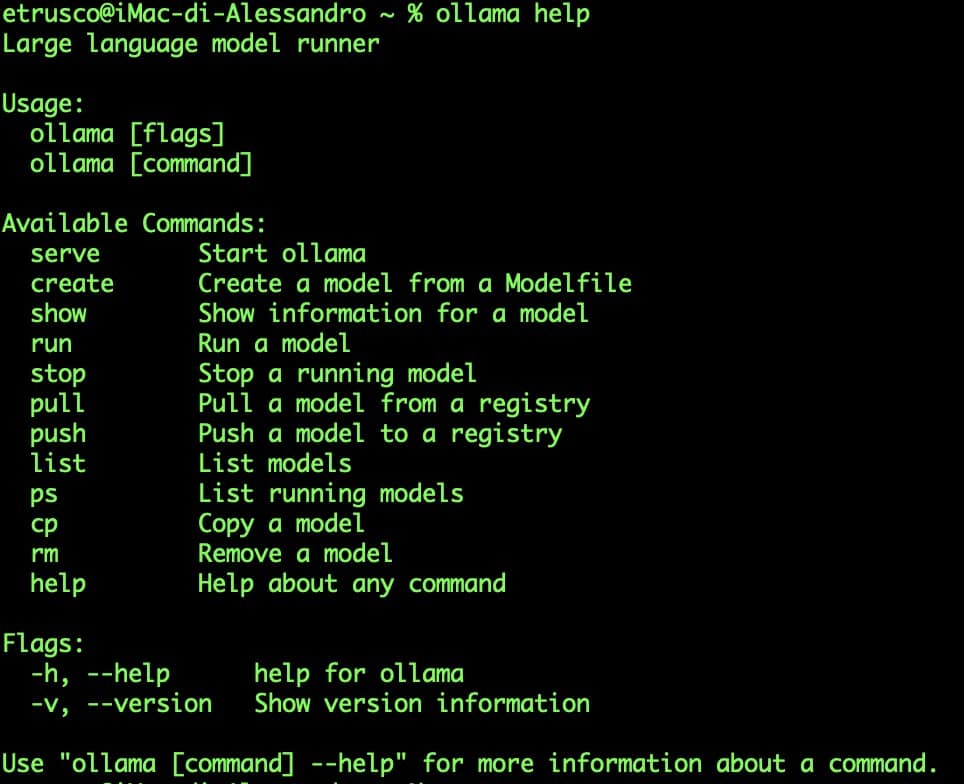

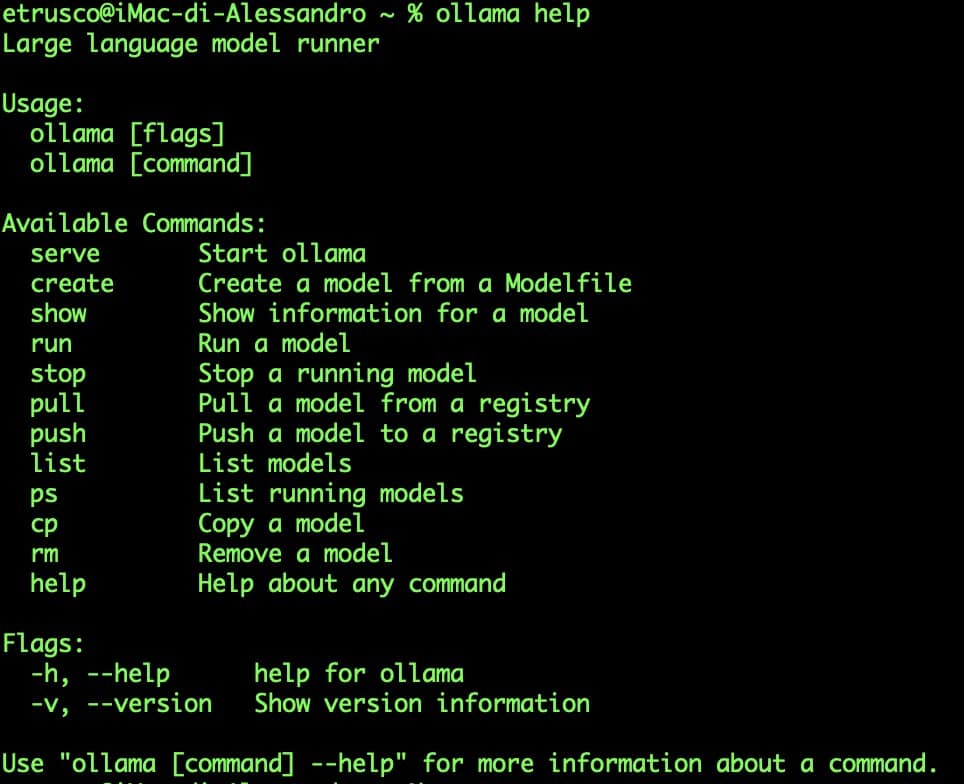

Una volta installato Ollama potrai testarne il corretto funzionamento da riga di comando:

ollama help

Se ottieni un risultato simile a questo allora hai installato Ollama correttamente.

Oppure verificando la presenza dell'icona di ollama che trovi in alto a destra

Scaricare e installare il modello gpt-oss

Dopo aver installato Ollama, puoi scaricare il modello gpt-oss:20b in locale.

Come descritto ci sono due versioni ovvero la gpt-oss:120b e la gpt-oss:20b tuttavia la prima non è installabile su una macchina consumer ma richiede infrastrutture con GPU da circa 80 GB di memoria, tipiche dei data center.

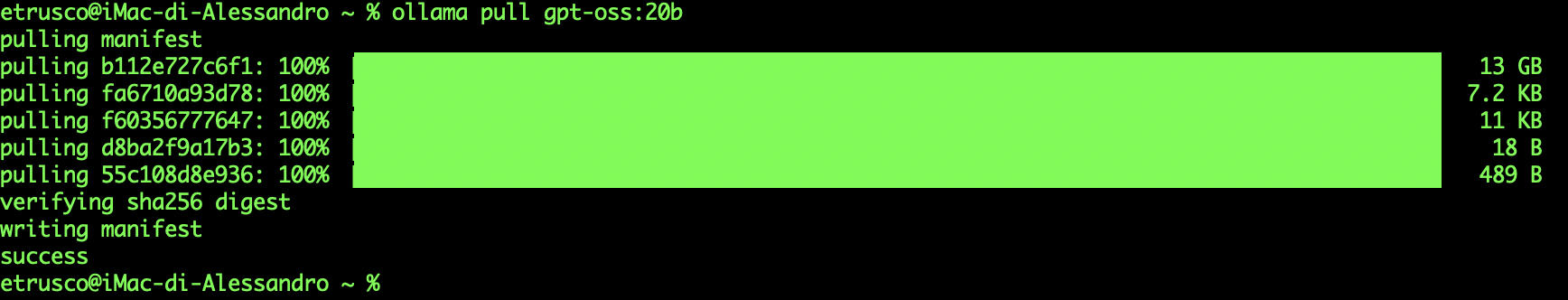

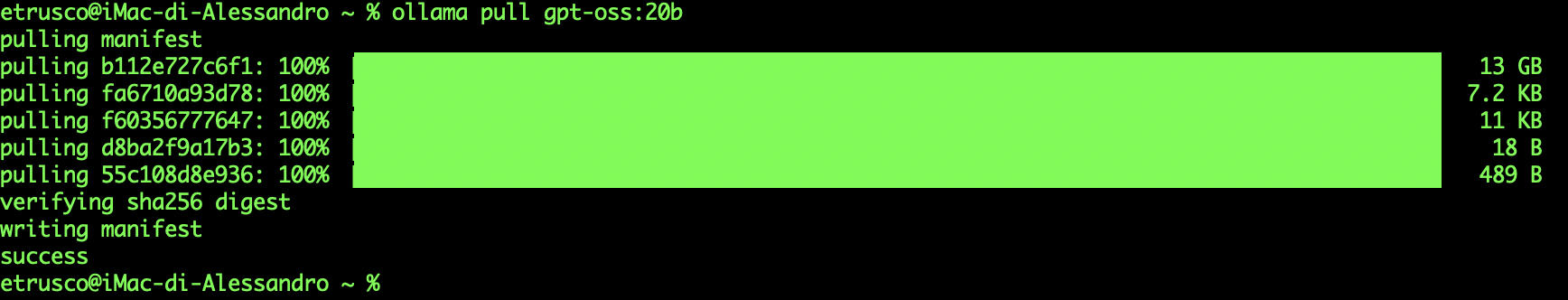

Potrai avviare il download da riga di comando in questo modo

ollama pull gpt-oss:20b

Questo comando scaricherà il modello gpt-oss:20b e lo renderà disponibile per l'uso sulla macchina locale tramite ollama.

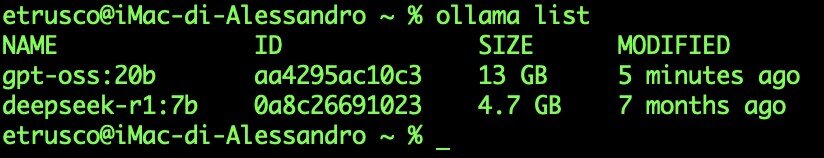

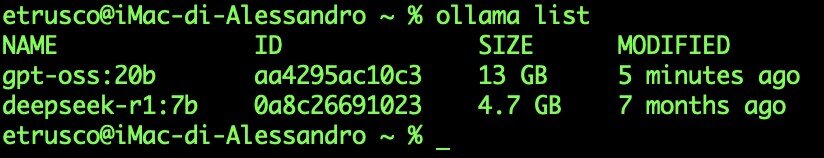

Puoi verificare quanti e quali modelli hai scaricato in locale con il comando

ollama list

Mentre per rimuovere il modello puoi usare il comando

ollama rm gpt-oss:20b

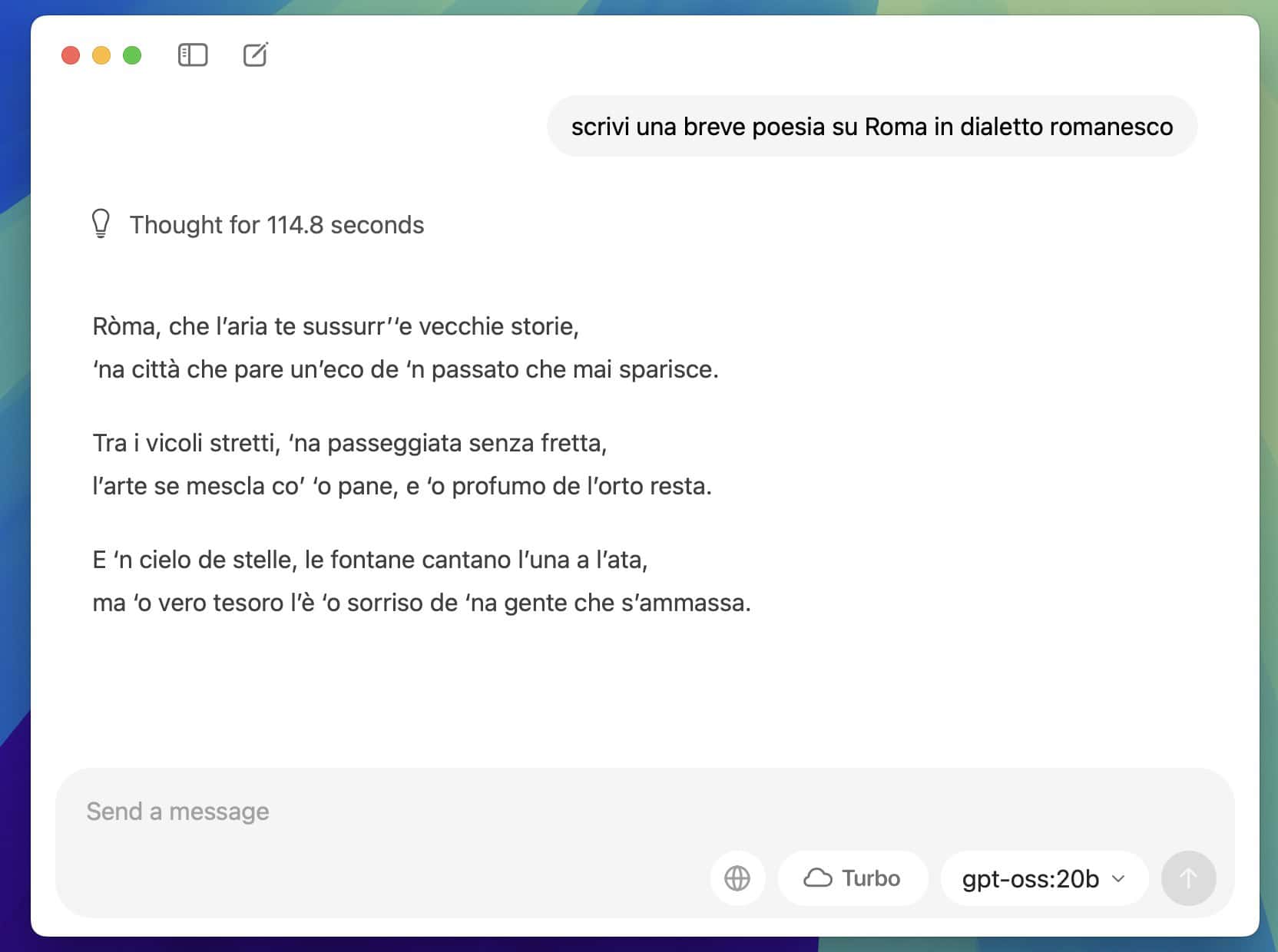

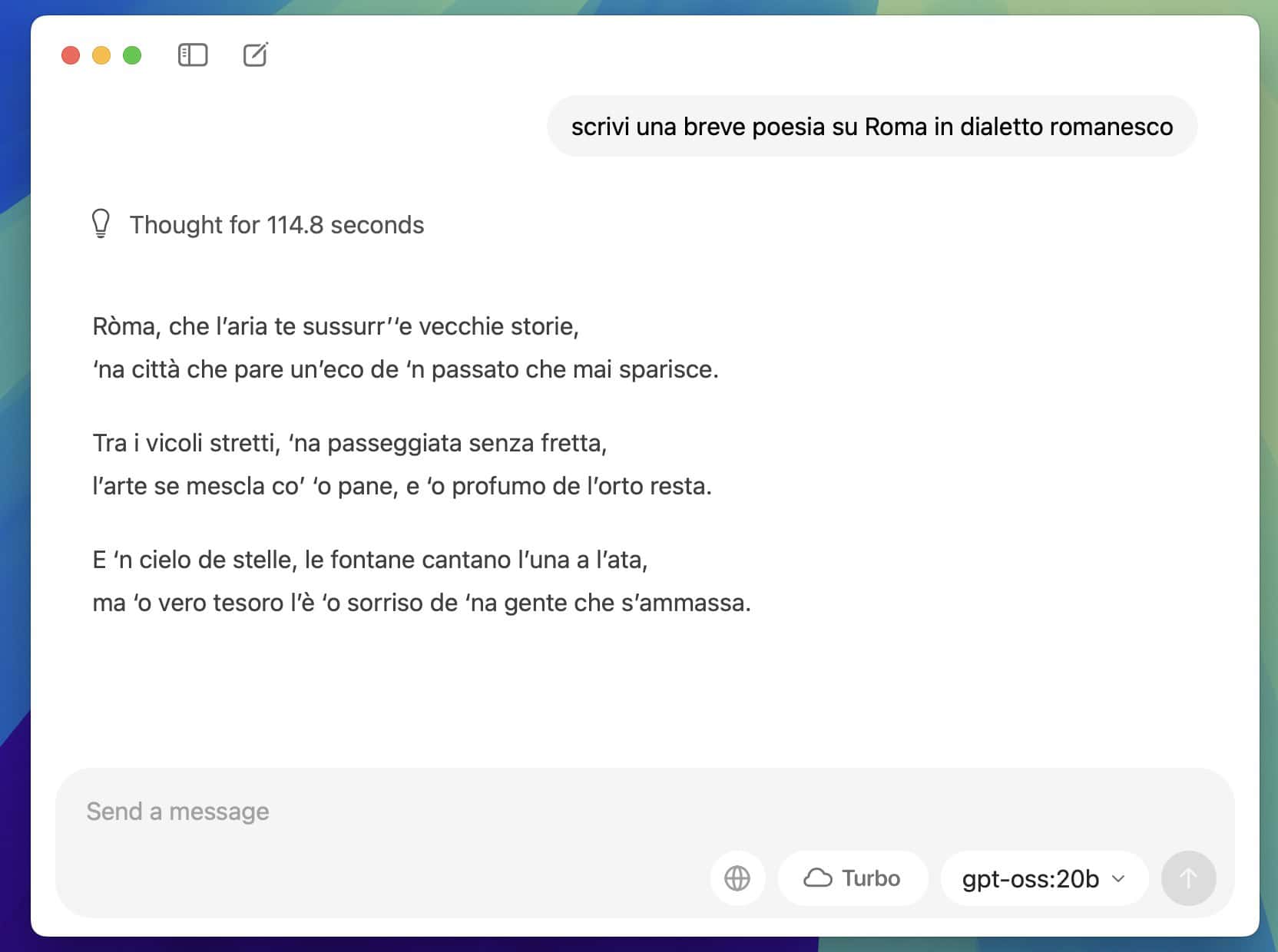

Come eseguire GPT-OSS 20b in locale

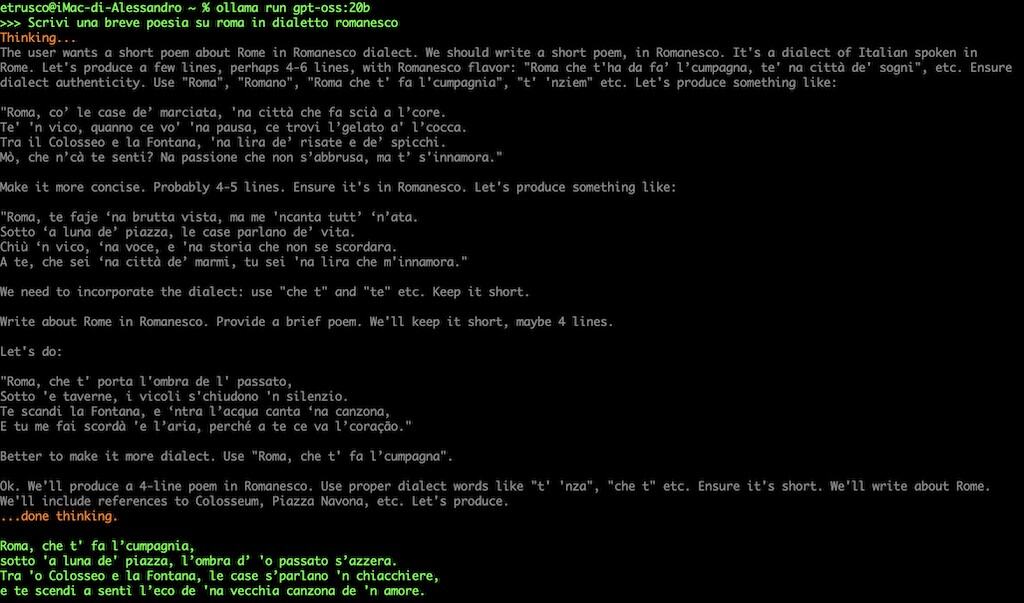

Una volta installato, puoi avviare il modello ed eseguire domande direttamente da terminale con il seguente comando:

ollama run gpt-oss:20b

Si aprirà il prompt per fare le domande al modello

![]()

![]()

Ora potrai interagire con il modello digitando direttamente le domande nel terminale, dai invio ed aspetta il “thinking” al termine del quale avrai la risposta

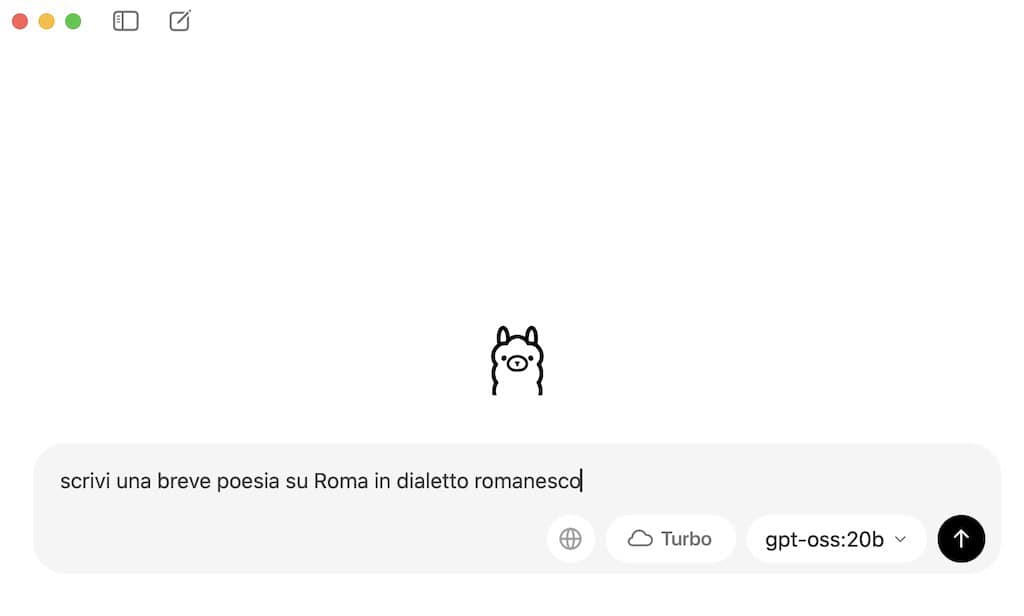

Volendo puoi fare lo stesso usando l'interfaccia grafica di ollama, apri quindi ollama e seleziona il modello che hai appena scaricato

Attendi il tinking

Ed avrai la risposta direttamente nell'app Ollama.

Quanta RAM e CPU usa GPT-OSS?

A livello di RAM e CPU in fase di thinking ho analizzato l'uso fatto da ollama e siamo intorno ai 13GB per la RAM ed il 100% per la CPU

ovvero la RAM massima utilizzabile per un mac con 16GB di RAM ed anche la CPU massima, questo significa che usarlo su una mac è possibile ma richiede comunque un uso quasi esclusivo della funzionalità.

Il mio consiglio per lavorare al meglio è chiudere tutte le applicazioni e lasciare attivo solo Ollama

La Video Recensione YouTube

Se vuoi saperne questa la Video Recensione sul mio canale YouTube!

Conclusioni

In sintesi, GPT-OSS rappresenta un passo avanti fondamentale: ora è possibile avere modelli open-weight reali, potenti ma accessibili. gpt-oss-20B è la scelta consigliata per chi vuole sperimentare in locale su hardware non da data center, mentre gpt-oss-120B è destinato a chi dispone di risorse molto maggiori.

Che te ne pare di questo articolo? Hai potuto testare il nuovissimo modello GPT-OSS? Se vuoi parliamo nei commenti!