Ti stai chiedendo come funziona ChatGPT 4? Vuoi saperne di più sui modelli gpt-3.5-turbo e gpt-4 di ChatGPT? Vorresti approfondire le differenze con il modello text-davinci-003?

Allora seguimi in questo articolo nel quale vedremo insieme le caratteristiche introdotte da OpenAI sul tema dei modelli di intelligenza artificiale specifici per creare programmaticamente un chatbot consultabili tramite API Rest e librerie.

Queste modifiche sono particolarmente interessanti, soprattutto in relazione al nuovo modello gpt-4 di ChatGPT V4 che verrà reso disponibile a breve come modello consultabile tramite api rest e librerie standard.

Nel momento in cui scrivo l'articolo non è ancora possibile testare il modello gpt-4 tramite api REST/librerie, ma solo in anteprima web sul sito ufficiale di OpenAI e solo attivando un piano Plus a pagamento al costo di 20$ / mese + IVA.

Per cui in questo tutorial concentrerò la mia attenzione sul modello gpt-3.5-turbo, introdotto da poco da OpenAI e che è il modello alla base di ChatGPT, precursore del modello gpt-4 e che ha delle sostanziali differenze rispetto al modello text-davinci-003.

I contenuti dell'articolo

Se non sai come funzionano le API Rest di OpenAI e come integrare ChatGPT in una applicazione esistente allora ti consiglio di leggere questo mio articolo

GPT-4 consultabile in abbonamento con ChatGPT Plus

Da qualche giorno è disponibile sul website di OpenAI in anteprima per i clienti premium una primissima versione 4 di ChatGPT, ancora non rilasciata ufficialmente, almeno in termini di modelli disponibili e consultabili tramite API REST e librerie.

Se sei un cliente premium ossia se hai sottoscritto l'abbonamento a ChatGPT Plus potrai interrogare via web il nuovissimo modello GPT-4 al costo di 20$ / mese + IVA.

Una volta sottoscritto l'abbonamento potrai iniziare a testare in anteprima le nuove funzionalità di ChatGPT 4 (modello gpt-4)

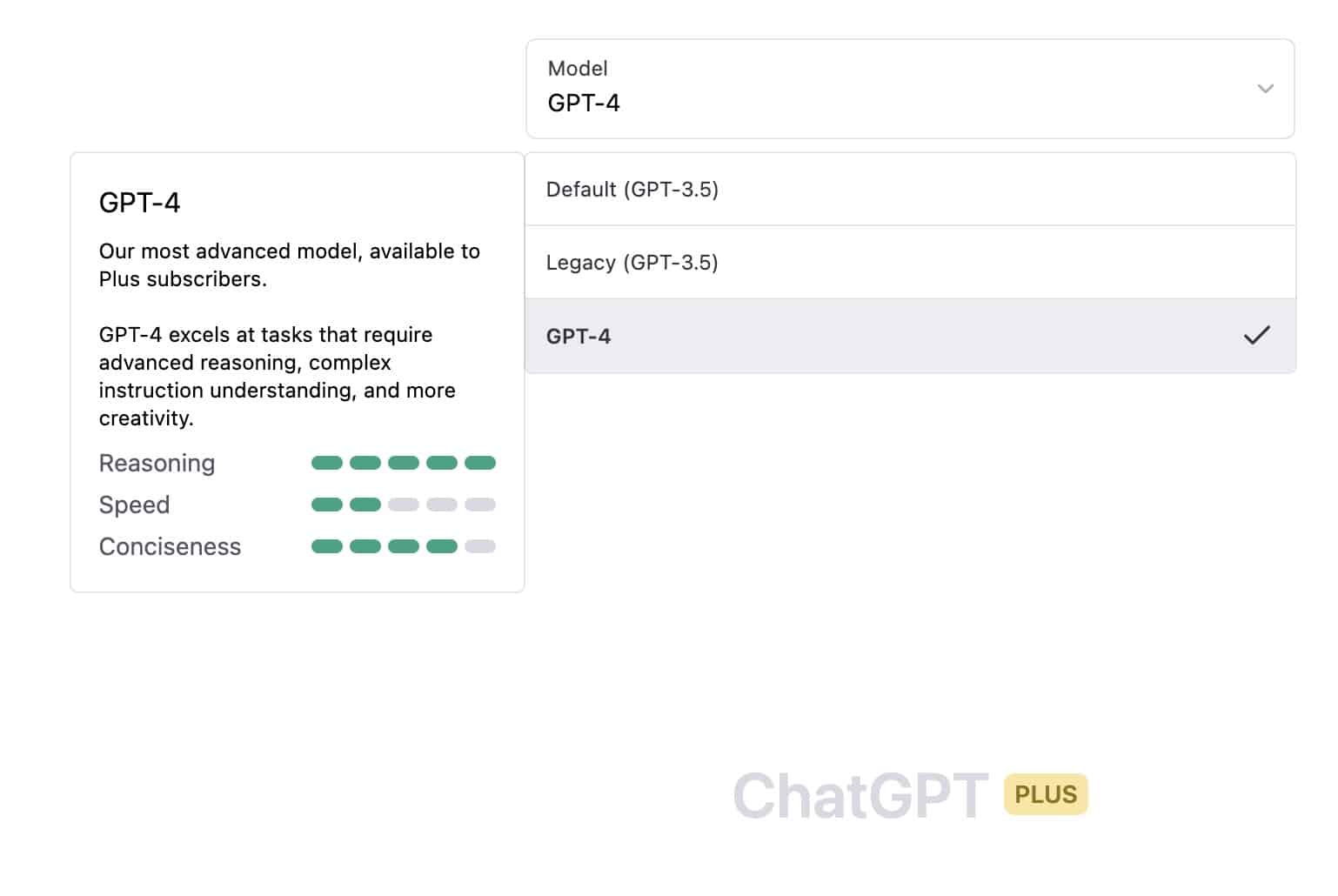

Considera che l'interfaccia è la stessa del ChatGPT-3, l'unica e sostanziale differenza è nella possibilità di selezionare il modello gpt-4 per le interrogazioni (vedi figura).

GPT-4 vs GPT-3

Ma quali sono le differenze tra i modelli GPT-4 e GPT-3?

Mettendo a confronto i due modelli possiamo vedere come le differenze sostanziali siano le seguenti:

- Dimensione del modello

- Capacità di apprendimento

- Efficienza energetica

- Personalizzazione e adattabilità

- Contesto e comprensione

- Etica e sicurezza

Vediamo ogni singola differenza nel dettaglio.

Dimensione del modello

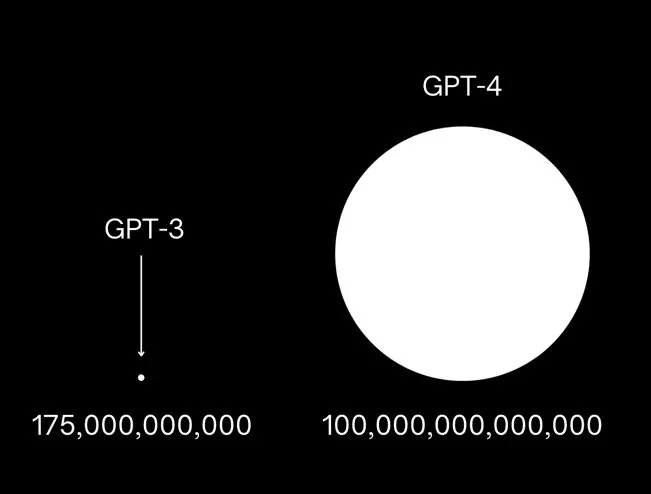

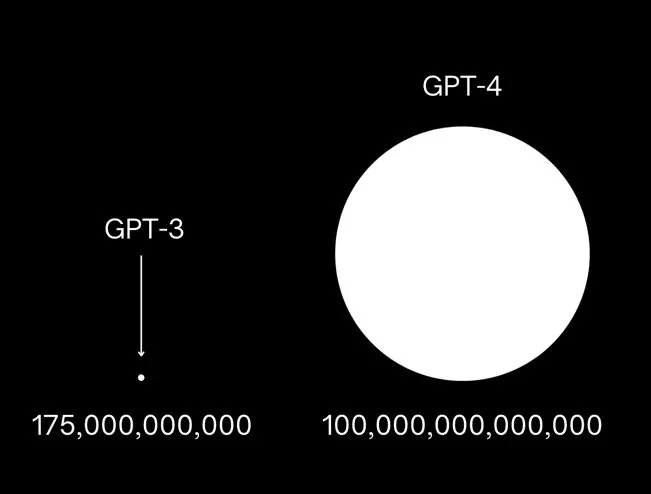

GPT-4 sarà significativamente più grande di GPT-3 in termini di parametri, il che gli permetterà di comprendere e generare linguaggio più complesso e accurato.

Considera che GPT-3 contiene 175 miliardi di parametri, mentre GPT-4 avrà un numero molto maggiore di parametri, si ipotizza che saranno circa 10.000 miliardi.

Capacità di apprendimento

GPT-4 sarà in grado di apprendere nuovi concetti e informazioni più rapidamente e accuratamente rispetto a GPT-3, grazie a una maggiore capacità di elaborazione e a potenziali miglioramenti negli algoritmi di apprendimento.

Efficienza energetica

GPT-4 è stato progettato per essere più efficiente dal punto di vista energetico, riducendo il consumo di risorse computazionali senza per questo sacrificare le prestazioni.

Personalizzazione e adattabilità

GPT-4 offrirà una maggiore capacità di personalizzazione e adattabilità per addestrare il modello su specifici domini o compiti, rendendolo più utile in una gamma sempre più ampia di applicazioni.

In questo articolo ci concentreremo sul modello gpt-3.5-turbo e sulle caratteristiche ed innovazioni che potremmo poi ritrovare anche nel modello gpt-4

Contesto e comprensione

GPT-4 sarà in grado di gestire il contesto e la comprensione del testo in modo più efficace rispetto a GPT-3, consentendo una maggiore coerenza e accuratezza nelle risposte generate.

Etica e sicurezza

Per concludere GPT-4 includerà notevoli miglioramenti in termini di etica e sicurezza, come il filtraggio di contenuti inappropriati o offensivi e la riduzione dei bias presenti nel modello.

E' possibile sin da ora testare le caratteristiche in tema di etica e sicurezza usando il modello moderations

Questo modello è invocabile sin da subito tramite post e ritorna informazioni su un testo generico fornendo una serie di flag:

"hate": false, "hate/threatening": false, "self-harm": false, "sexual": false, "sexual/minors": false, "violence": false, "violence/graphic": false

che identificano la qualità del contenuto stesso.

Questo endpoint può essere utilizzato dai developer per filtrare in input eventuali contenuti ritenuti offensivi o volgari.

Ora analizziamo il modello gpt-3.5-turbo che può essere interrogato tramite API Rest e che possiamo considerare il precursore del modello gpt-4 che verrà rilasciato a breve per essere interrogato tramite API.

Il Modello gpt-3.5-turbo

Il modello gpt-3.5-turbo è il modello utilizzato da ChatGPT quando fai una interrogazione web sulla pagina ufficiale di OpenAI.

Maggiori informazioni sui modelli di OpenAI a questo link.

Si differenzia dal classico text-davinci-0003 perchè consente di impostare una serie di parametri specifici proprio di un chat bot.

L'endpoint del modello gpt-3.5-turbo è il seguente

POST https://api.openai.com/v1/chat/completions

e questo un esempio di chiamata tramite curl

curl https://api.openai.com/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer $OPENAI_API_KEY" \

-d '{

"model": "gpt-3.5-turbo",

"messages": [{"role": "user", "content": "Hello!"}]

}'Se non sai come generare la chiave api di openai ti spiego qui come fare.

La cosa interessante da analizzare nella chiamata è relativa alla struttura del “messages” che a differenza del tradizionale “completion” del modello text-davinci-003 ha anche il campo “role” oltre al classico campo “content”.

Il campo role può assumere uno dei seguenti valori: “system“, “user“, “assistant” dove system è solitamente il contenuto associato al messaggio iniziale di sistema, user è il contenuto associato ai messaggi degli utenti e assistant è il contenuto associato alle risposte di ChatGPT.

Questo un esempio più complesso di messaggio da inviare all'endpoint

{

"model": "gpt-3.5-turbo",

"messages": [

{"role": "system", "content": "Benvenuto nel sistema di AI Assistant di pensando.it"},

{"role": "user", "content": "Chi ha vinto il campionato italiano di calcio nel 2001?"},

{"role": "assistant", "content": "Il campionato italiano di calcio del 2001

è stato vinto dalla squadra della AS Roma."},

{"role": "user", "content": "Chi è stato il capocannoniere?"}

]

}Inviando questa richiesta, che in se include già una storia di domande e risposte, l'output sarà il seguente:

{

"id": "chatcmpl-6v2VxuU8tVZjVshzlYdNQxFHlqIkF",

"object": "chat.completion",

"created": 1679052381,

"model": "gpt-3.5-turbo-0301",

"usage": {

"prompt_tokens": 83,

"completion_tokens": 42,

"total_tokens": 125

},

"choices": [

{

"message": {

"role": "assistant",

"content": "Il capocannoniere del campionato italiano di calcio del 2001 è stato Dario Hübner,

calciatore italiano dell'Atalanta, con 24 gol."

},

"finish_reason": "stop",

"index": 0

}

]

}Come si vede dalla risposta, questa è correlata a tutta la discussione e non si limita solo all'ultima domanda che, di per se, non avrebbe tutte le informazioni necessarie per essere evasa (Chi è stato il capocannoniere?).

Mentre nel contesto della chat e dei ruoli assegnati ad ogni singolo messaggio assume un significato molto chiaro ossia “Chi è stato il capocannoniere del campionato italiano di calcio vinto dalla AS Roma nel 2001“.

Puoi ben vedere, quindi, come il modello sia molto più aderente alle esigenze tipiche di un chat bot o di un sistema di messaging simile a ChatGPT.

Contattami per una Consulenza

L'argomento è troppo tecnico? Vorresti integrare ChatGPT ma non hai le competenze per realizzarlo?

Se vuoi approfondire l‘argomento e ti serve un esperto in materia di integrazione tra applicazioni non esitare a contattarmi per una consulenza.

Fissa subito un appuntamento gratuito di 30 minuti, potremo conoscerci meglio e verificare come collaborare!

Il video tutorial YouTube

Questa il mio video tutorial YouTube nel quale in concreto ti faccio vedere come funziona il modello gpt-3.5-turbo e come integrarlo in concreto in una applicazione sviluppata in Java per realizzare un semplice chatbot.

Conclusioni

Da pochi giorni è disponibile ChatGPT-4 in anteprima web per i clienti che hanno sottoscritto l'abbonamento Plus di OpenAI.

Al momento in cui scrivo l'articolo il modello gpt-4 non è ancora interrogabile via API rest, mentre è possibile interrogare il modello gpt-3.5-turbo, precursore del modello gpt-4.

In questo articolo abbiamo visto le caratteristiche introdotte da OpenAI sul tema dei modelli di intelligenza artificiale specifici per creare programmaticamente un chatbot usando le API Rest, proprio in relazione al modello gpt-3.5-turbo.

Rimaniamo quindi in attesa del rilascio ufficiale del modello gpt-4 interrogabile tramite API Rest e librerie, per verificare quelle che saranno le sostanziali differenze con il modello precursore gpt-3.5-turbo.

Se l'articolo ti è piaciuto parliamone insieme nei commenti! Sarò lieto di risponderti nel più breve tempo possibile.